王亦洲课题组 NeurIPS 2023 入选论文解读:ChimpACT:理解黑猩猩行为的纵向数据集

本文是对发表于人工智能领域顶级会议 NeurIPS 2023 的论文 ChimpACT: A Longitudinal Dataset for Understanding Chimpanzee Behaviors 的解读。该论文由北京大学王亦洲课题组、北京大学朱毅鑫课题组与美国加州大学圣地亚哥分校(UCSD)认知科学学院 Federico Rossano 教授团队跨学科、全球合作完成。

该研究提出了 ChimpACT,这是第一个全面可用于研究黑猩猩行为的纵向数据集,具有丰富的注释标签。实验证明,ChimpACT 具有很高的挑战性,可为研究灵长类动物个体情况、群体社会结构提供高效的强有力的支持。

论文链接:https://openreview.net/pdf?id=393EoKpJN3

项目代码:https://github.com/ShirleyMaxx/ChimpACT

主页&数据集:https://shirleymaxx.github.io/ChimpACT/

视频介绍:https://vimeo.com/876025855

图1. ChimpACT 数据集和其丰富的标注(包括个体识别、追踪,姿态,细粒度行为等)。这是 Swela 在哺育她的孩子 Azibo。

01 背景介绍

了解非人类灵长类动物的行为对于改善动物福利[1]、建模社会行为以及深入了解人类特有和系统发育共享的行为[2]至关重要。然而,缺乏关于非人类灵长类动物行为的数据集阻碍了对灵长类社会互动的深入探索,给我们最近的亲属研究[2]带来了挑战。传统的对灵长类动物进行进化人类学研究通常需要研究者深入野生动物保护区,对灵长类动物进行长时间甚至数年的观察和采集数据[3,4],以保证数据的真实性。然而野生动物活动范围较大,采集数据过程艰难,且纯人工的采集会受到更多的主观和客观因素干扰,比如采集时间和采集区域范围。此外,对采集到的数据进行数据清洗和编码处理也需要具有专家知识的研究者花费大量时间,易受到主观因素影响。

近年来,人工智能技术的蓬勃发展为提高野外动物如灵长类动物的研究效率带来了可能的途径[5,6]。例如英国牛津大学教授 Andrew Zisserman 教授团队[5]采集了13只黑猩猩在长达两年时间内的行为活动,整理出共计10个小时的视频,构建了 CCR 黑猩猩数据集(如图2a 所示),并对收集到的数据进行初步的行为识别。但是该数据集涉及的保护区范围较小,灵长类动物的社会结构不明晰,且对同一个社会群体的观察时间过短,因此只能进行初级的部分简单行为的识别,而无法通过此数据集探索灵长类野生动物的社会属性、社会角色,因此很难得到社会性研究方面的结论。

类似的,苏黎世联邦理工学院神经科学教授 Mehmet Fatih Yanik 团队[6]发表的基于深度学习的追踪识别灵长类动物的文章尝试对灵长类动物间的互动行为进行识别。但是该文章中提出的数据集仅仅涉及4只猕猴类动物,且均圈养在15平方米内的实验环境(如图2b 所示),一方面导致数据多样性全面性较差,社会结构非常简单,另一方面动物也因为人工饲养的因素而失去野生动物一些原本的习性,造成有偏差的结论。

图2. 近年实验室设置下的 AI 方法尝试。(a) CCR 黑猩猩数据集,(b) 猕猴数据集。

02 ChimpACT 数据集

为了解决这些限制,我们提出了 ChimpACT,一个全面的数据集,用于量化社会群体中黑猩猩的长期行为和社会关系。ChimpACT 跨越2015年到2018年,包含了德国莱比锡动物园(Leipzig Zoo)的一个由20多只黑猩猩组成的群体的视频,特别关注记录一只年轻雄性 Azibo 黑猩猩的成长发展轨迹。ChimpACT 既全面又具有挑战性,包括163个视频,累计160,500帧,每个视频都有检测、识别、姿势估计和精细的时空行为标签进行丰富注释。

图3. ChimpACT 数据集与现有灵长类动物行为数据集的比较。方括号内的数字表示黑猩猩类别的标签计数。∅表示无证。对于“Species”(物种)列,G 代表一般物种,P 代表灵长类动物,M 代表猕猴,C 代表黑猩猩。在“Source”(来源)列中,I 代表互联网,Z 代表动物园,C 代表笼子,W 代表野生,CP 代表圈养。

图3展示了 ChimpACT 数据集与现有灵长类动物行为数据集的比较。可以看出 ChimpACT 数据集是现有的最大最全面的灵长类动物行为数据集,具有以下三个特性:(1) 纵向数据,(2) 半自然的生活和社交环境,(3) 行为图谱。

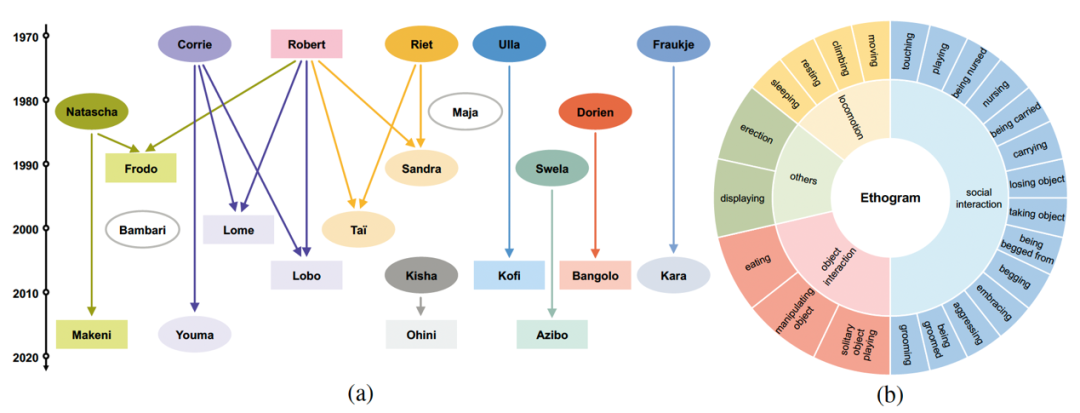

纵向数据:ChimpACT 跨越四年时间,通过追踪一只固定居住在动物园的年轻黑猩猩 Azibo 及其群体的生活,提供了难得的机会来深入了解黑猩猩社交化、社交技能的演化、社会关系的形成和群体特定文化行为的习得过程。该黑猩猩群体有着定义好的社会血缘关系,如图4a 所示。

半自然的生活和社交环境:ChimpACT 捕捉到了莱比锡动物园黑猩猩在半自然栖息地中的情景,包括室内和室外场景。室内空间设有丰富的环境丰富化措施,而室外区域则包含植被和人工河流。这种多样化的环境确保了该数据集动物行为的通用性和真实性。如图1所示。

行为图谱:更加值得一提的是,ChimpACT 是第一个为机器学习和计算机视觉领域提供黑猩猩行为图谱(Ethogram)的数据集。这个由灵长类学家定制的行为图谱将黑猩猩日常行为分为:运动(Locomotion)、物体交互(Object interaction)、社交交互(Social interaction)等,每一类都包含研究者们精心定义的详细动作子类。如图4b 所示。

图4. (a) ChimpACT 黑猩猩群体的亲缘关系。矩形和椭圆形分别代表雄性和雌性,箭头从父母流向孩子。它们相对于时间轴的垂直位置表示出生年份。(b) ChimpACT 黑猩猩行为图谱。

图5-7分别展示了 ChimpACT 数据集中对黑猩猩(i)个体追踪识别,(ii)姿态,以及(iii)时空行为的精细化标注。

图5. ChimpACT 数据集对黑猩猩个体追踪识别的标注。

图6. ChimpACT 数据集对黑猩猩个体姿态的标注。

图7. ChimpACT 数据集对黑猩猩个体的时空行为标注。

03 实验验证

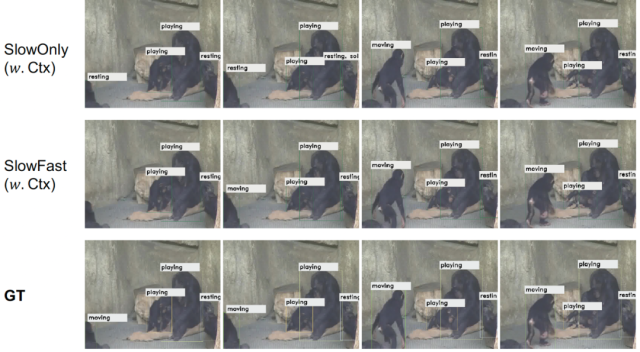

我们在 ChimpACT 上对三个计算机视觉任务的代表性方法进行了基准测试:(i)追踪和识别,(ii)姿态估计,以及(iii)黑猩猩的时空行为检测。我们的实验证明,ChimpACT 为设计新方法和改进现有方法以解决应用于黑猩猩群体的基本计算机视觉任务(如检测、姿势估计和行为分析)提供了充足的机会,加深了我们对非人类灵长类动物中的交流和社会性的理解。图8-10展示了三个任务的代表性方法在 ChimpACT 测试集上的定性可视化效果。

图8. 黑猩猩个体追踪识别任务在 ChimpACT 测试集上代表性方法的定性结果。

图9. 黑猩猩个体姿态检测任务在 ChimpACT 测试集上代表性方法的定性结果。

图10. 黑猩猩个体时空行为检测任务在 ChimpACT 测试集上代表性方法的定性结果。

04 总 结

本工作提出了 ChimpACT,第一个全面可用于研究黑猩猩行为的数据集。该数据集丰富的标注可以让研究人员更深入地研究黑猩猩的行为,为跨学科研究搭建了桥梁,涵盖了灵长类学、比较心理学、计算机视觉和机器学习等领域。通过提供这一资源,作者的愿景是促进激发研究界为非人类灵长类动物开发专门技术,深化人类对灵长类动物复杂社会结构和动态的共同洞察力。

更多视频和数据集请访问项目主页:https://shirleymaxx.github.io/ChimpACT/

参考文献

[1] Dawkins, M. S. (2003). Behaviour as a tool in the assessment of animal welfare. Zoology, 106(4):383–387.

[2] The Chimpanzee Sequencing and Analysis Consortium (2005). Initial sequence of the chimpanzee genome and comparison with the human genome. Nature, 437(7055):69–87.

[3] Hobaiter, C., Samuni, L., Mullins, C., Akankwasa, W. J., and Zuberbühler, K. (2017). Variation in hunting behaviour in neighbouring chimpanzee communities in the budongo forest, uganda. PloS One, 12(6):e0178065.

[4] Fröhlich, M., Müller, G., Zeiträg, C., Wittig, R. M., and Pika, S. (2020). Begging and social tolerance: Food solicitation tactics in young chimpanzees (pan troglodytes) in the wild. Evolution and Human Behavior, 41(2):126–135.

[5] Bain, M., Nagrani, A., Schofield, D., and Zisserman, A. (2019). Count, crop and recognise: Fine-grained recognition in the wild. In Proceedings of the IEEE/CVF International Conference on Computer Vision Workshops.

[6] Marks, M., Jin, Q., Sturman, O., von Ziegler, L., Kollmorgen, S., von der Behrens, W., Mante, V., Bohacek, J., Yanik, M.F.: Deep-learning-based identification, tracking, pose estimation and behaviour classification of interacting primates and mice in complex environments. Nature Machine Intelligence 4(4), 331–340 (2022).