董豪课题组 ECCV 2022 入选论文解读:机器人的交互感知与物体操作

本文是计算机视觉领域顶级会议 ECCV 2022入选论文 AdaAfford: Learning to Adapt Manipulation Affordance for 3D Articulated Objects via Few-shot Interactions 的解读。该论文由北京大学董豪团队与斯坦福大学、腾讯 AI lab 和鹏城实验室合作完成。文章让机器人具备通过与环境/物体交互,以获得对应的结构信息,更好地实现机器人操作任务。

项目主页:https://hyperplane-lab.github.io/AdaAfford/

01 研究背景

当前背景下,高新科技快速发展,人们的生活愈发智能化,大量家庭助理机器人逐渐走入人们的日常生活。随之而来的是新型机器人与多样化的家具进行交互问题,如何赋予机器人这种能力成为了研究热点。怎样让机器人准确开关形状各异的抽屉、旋转门把手、开关水龙头?这些都成为了值得研究与探讨的问题。

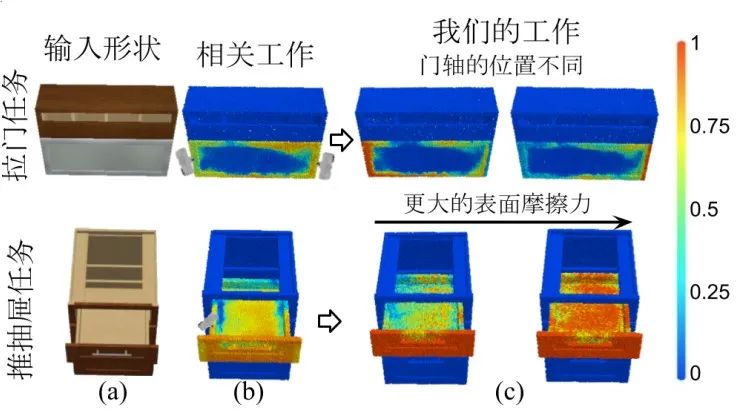

此前已有许多团队研究了对于家具的感知和操作的问题。我们把机器人操控任务成功的概率称之为可操作性。近年来,研究人员提出通过获取物体的视觉信息(图1 (a))预测物体的可操作性,如图1 (b) 所示,颜色越亮的位置意味着可操作性越大,机器人和可操作性越大的位置交互,就能够有越高的任务成功率。

然而,只利用视觉信息来预测可操作性会忽略许多重要的非视觉信息。我们假设一个与门交互的场景(图1拉门任务),对于一个没有门把手的隐形门,从视觉上我们只能了解到门当前的位置和大小,却无法获得门轴的具体位置和门能够拉开的极限角度,我们称之为运动学信息;我们也无法获得门轴的摩擦系数,我们称之为动力信息。这些不确定因素会使机器人预测的准确性大大降低。在本文中,我们提出了一个名为 AdaAfford 的新框架,它让机器人通过与物体进行若干次交互,来获得物体的运动学(如隐形门的门轴位置)和动力信息(如材质表面摩擦力),以得到准确的可操作性热度图,实现更为准确的操作,如图1 (c) 所示。

图1. 输入一个物体的视觉信息,我们的方法在主动进行了一些交互探索后,更准确合理的预测物体上的可操作性

视频介绍:https://www.bilibili.com/video/BV1tg41117yT

02 方 法

以物体的视觉信息作为智能体的输入,之前的工作可以直接输出可操作性图(图1 (b))。我们的工作继承了这些特性,不同的是我们的方法允许机器人先进行一些交互,并根据交互的结果提取物体的运动学信息和动力信息,并利用这些信息适应调整对物体的可操作性预测,以达到更好的效果。

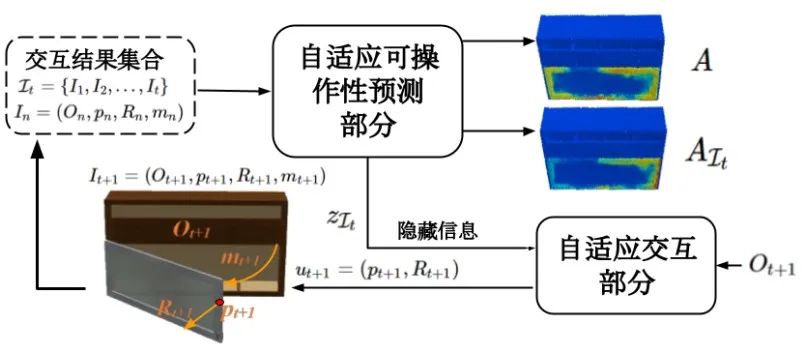

我们的工作主要由两个部分组成:自适应可操作性预测部分(下称“预测部分”)和自适应交互部分(下称“交互部分”)。

1. 预测部分以物体的视觉信息及额外交互结果为输入,输出可操作性性预测和向量 z,这里向量 z 表示交互所得的信息。

2. 交互部分以物体的视觉信息及向量 z 为输入,输出对于物体的动作,通过这部分得到的交互往往会含有更多的信息量。

图2. 框架结构

图2给出了该方法的概述。我们使用交互部分来生成与物体的交互,交互结果存储在一个集合中输入给预测部分,预测部分从交互结果中提取相关信息,并将所得信息输入给交互部分,交互部分在得到相关信息后继续生成新的交互形成循环结构。详细内容请参考项目主页和论文。

03 实 验

我们利用大型 PartNet-Mobility 数据集和 SAPIEN 模拟器来进行实验。实验结果证明了所提出方法的有效性和优越性。为了模拟操纵具有不确定动力学参数的物体,我们随机在 SAPIEN 中改变以下三个物理参数:1) 物体轴上的摩擦力,2) 目标部件的质量,3) 物体表面摩擦系数。

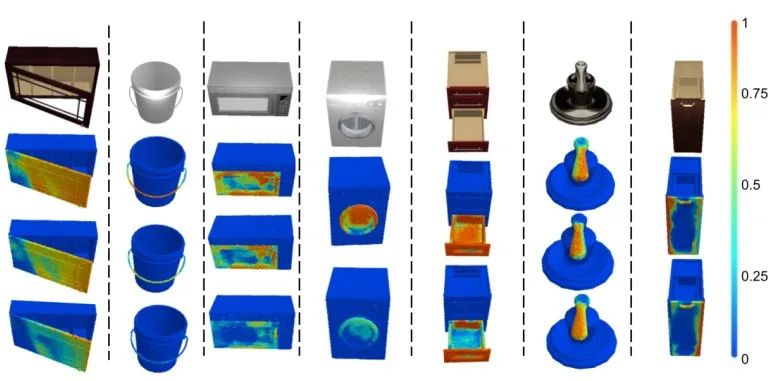

图3显示了我们在不同的环境下预测的可操作性图。图中可以看出,我们提出的方法成功地适应了不同的环境,进行了更好的可操作性预测。在同一视觉输入下,它们输出了不同的可操作性图,这表明预测部分从交互结果中提取出了有用的信息。在第一、二列中,我们分别观察到关节摩擦较大的门和水桶把手较难操作,在离轴较远的位置上才能完成推拉操作。在右边第二栏,我们的网络成功地预测了正确操作。

图3. 同一外观下由于隐藏的物理性质不同造成可操作性预测的差异

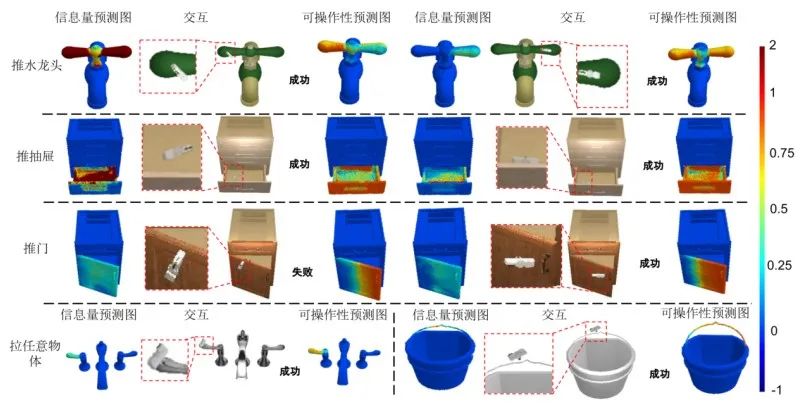

图4进一步展示了我们交互部分的方案,同时也展示了交互结果对可操作性预测的影响以及对新交互生成的一些影响。例如,在第一行,仅在视觉信息下,交互部分建议在水龙头的两端进行交互,与左边交互获知其可操作后,在第二个时间步建议在另一边交互。第一、三两行表明过去的交互结果将影响未来交互点的选择,证明了我们利用循环结构获得多次操作的必要性。在最后一行,我们展示了仅需一次交互就能得到足够结构信息的案例。

图4. 在一些物体上测试时交互的选择过程,以及可操作性预测图的变化过程

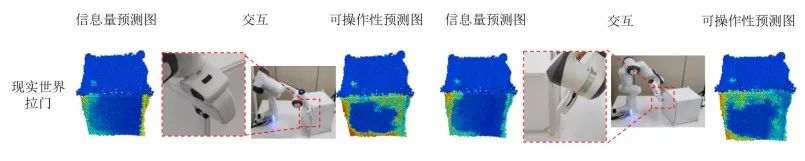

图5展示了我们的框架在真实世界中的一个实验结果,说明我们的框架可以某种意义上泛化到合成数据以外的数据分布。

图5. 真实世界的实验结果

04 总 结

综上所述,这篇论文中,我们为了消除非视觉信息对于感知和预测物体可操作性的影响,提出了一个新颖的 AdaAfford 框架,让机器人通过与环境/物体进行探索交互,获得结构信息,从而让机器更好地实现操作任务。实验结果证明了我们方法的有效性、优越性和可泛化性。