静5青年讲座回顾:麦络博士介绍低模型延迟的大规模深度学习推荐系统

2022年7月12日,爱丁堡大学(The University of Edinburgh)的助理教授麦络博士受邀于北京大学前沿计算研究中心作了题为“Ekko: A Large-Scale Deep Leaming Recommender System with Low-Latency Model Update”的在线报告。报告由中心助理教授董豪博士主持,相关内容通过蔻享学术、Bilibili 同步直播,线上数百人观看。

麦络博士做在线报告(报告视频:https://www.bilibili.com/video/BV1Pt4y1t7Te/)

讲座的开始,麦络博士首先简单介绍了深度学习推荐系统(DLRS)的发展以及面临的挑战。DLRS 需要时刻进行大规模的模型参数更新,降低模型参数更新的延迟对于提升 DLRS 的效率至关重要。当前,深度学习推荐系统在各种互联网服务上被广泛应用,系统时刻作用于数十亿的在线用户,任何微小的表现提升都能带来显著的收益。多项 SOLs(服务目标等级)被用来衡量系统的表现,而这些 SOLs 都是对系统延迟非常敏感的。目前被广泛使用的 DLRS 在更新模型时,通常采用检查点广播(Checkpoint-broadcast)、异步更新等方法,会带来比较大的延迟,影响 SOLs 表现。针对降低模型更新延迟的挑战,麦络博士团队与微信技术团队开发了一套低模型延迟的大规模深度学习推荐系统,命名为 Ekko。

麦络博士介绍了 Ekko 系统实现低延迟的三大创新机制:

1. P2P 的模型更新算法(Peer-to-peer model update algorithm),采用了缓存参数更新以及分块版本(shards version)的数据传输,降低了模型更新时数据传输的开销。

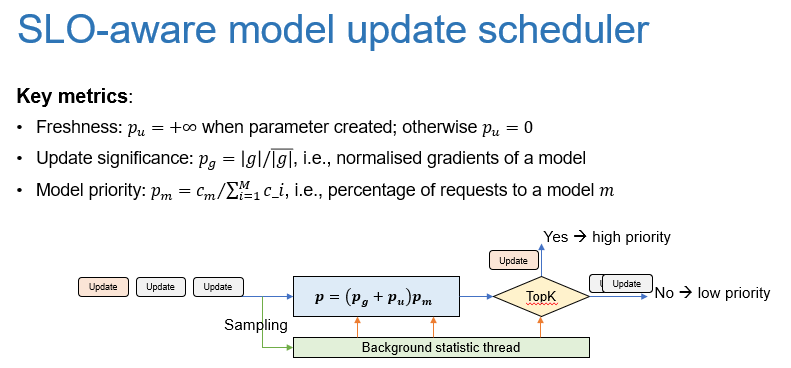

2. 针对服务级别目标的优先更新调度机制(SLO-aware model update scheduler),设计了一套评估指标衡量参数更新的优先级,优先更新对 SLOs 表现影响较大的少数参数。降低了需要更新的参数数量。

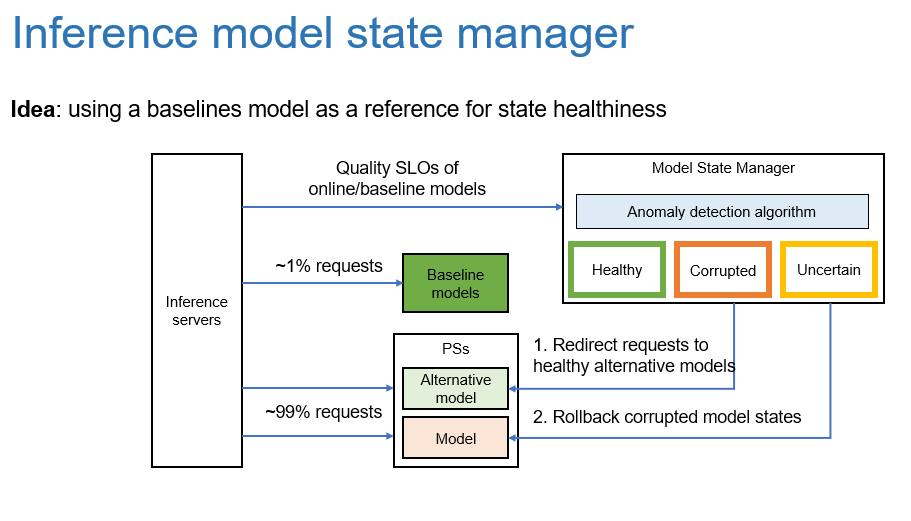

3. 推理模型状态管理器(Inference model state manager),对在线的推理模型进行监控,与 baseline 模型做性能比较,根据模型的性能和状态,对在线模型进行下线、回滚和重新上线。这一机制保护了在线模型不受未经评估的参数更新的负面影响。

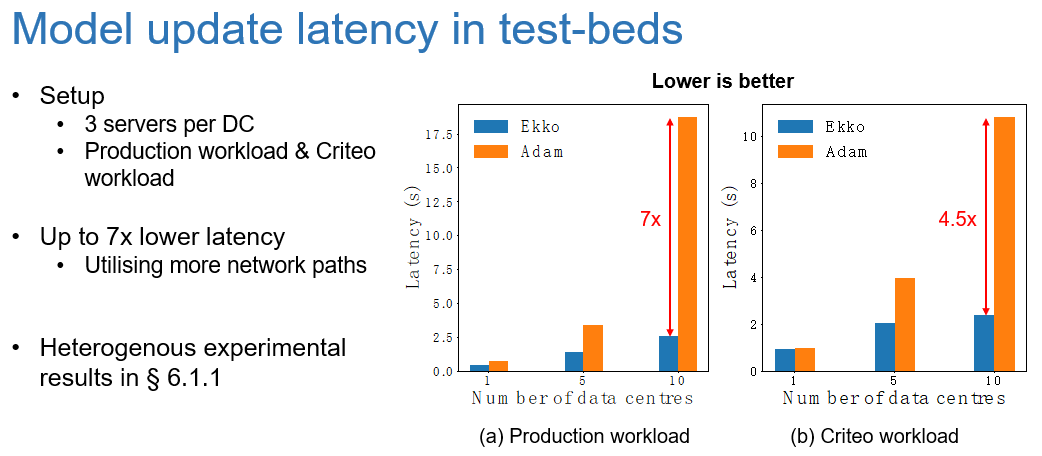

得益于这些降低延迟的创新机制,Ekko 系统在性能评估测试中取得了惊艳的结果。在小型测试环境中,Ekko 系统的模型更新延迟相较于 SOTA 的 Adam 系统最多降低了7倍。

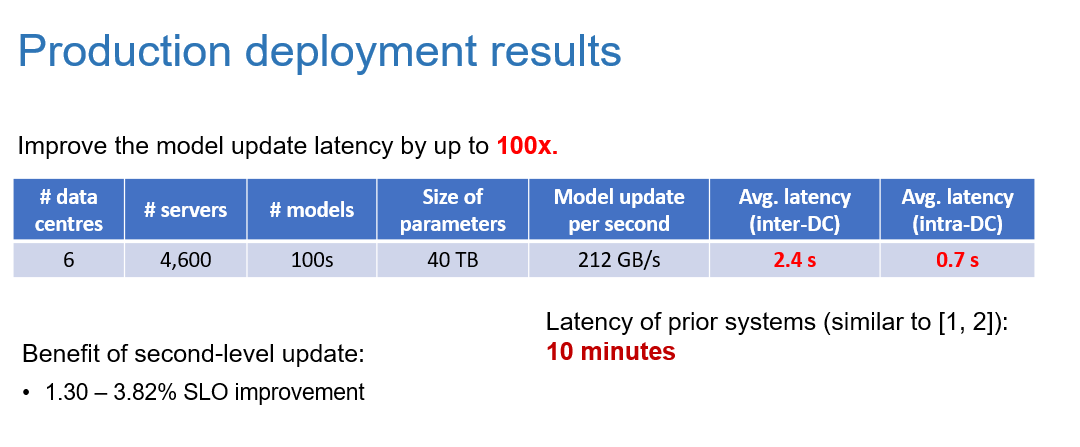

而在生产环境中,Ekko 系统部署于6个数据中心多达4600台服务器,共40 TB 的参数需要每秒更新200 GB。相较于现有系统,Ekko 系统的模型更新延迟降低了惊人的100倍。原本跨数据中心的参数更新延迟足足有10分钟之多,严重影响服务效率,而 Ekko 系统将这个延迟降低到了短短的2.4秒。

对于 Ekko 系统的未来,麦络博士描述了他的几项展望。首先是实现“低碳足迹”,降低大规模推理模型的算力和电力消耗;第二是高性能表现,包括支持 FPGA 等高效计算硬件以及分散的计算资源池等;第三是推荐系统的可控性,在 Web 3.0的时代保持深度学习推荐系统的可控性、可解释性和透明度。

讲座的最后,麦络博士与同学们对这一工作进行了讨论,并受董豪博士邀请,介绍了自己最新的《OpenMLSys》书籍和开源社区。《OpenMLSys》是世界上第一本全面讲述机器学习系统知识的开源书籍,它全面系统性地讲述了机器学习系统,注重基础,语言通熟易懂。麦络博士在教学的过程中发现,现有的机器学习教学缺乏课程来衔接机器学习技术和计算机系统知识,遂与董豪博士等好友开始了书籍的开源写作。书籍采取的开源写作的方式,逐渐让很多资深的 AI 框架的设计者参与到开源写作的工作中,形成了高度可扩展的 OpenMLSys 社区,保证这本书的可持续发展。欢迎大家阅读 OpenMLSys 并提出建议,也欢迎加入书籍的开源写作中。