【WINE 2020】Yiling Chen教授谈将算法纳入决策的挑战

2020年12月7日,哈佛大学教授 Yiling Chen 带来了题为《将算法纳入决策的挑战:公平、福利和差别性交互》的主旨报告。报告由中国科学院大学教授陈旭瑾主持。该报告讨论了当计算机算法被应用于实际社会问题的决策过程或辅助人们做决策时的两个挑战,一是对算法的公平性的要求会影响社会福利,二是人们与算法的交互方式会影响人们的决策过程。

Yiling Chen教授报告中

Yiling 首先介绍了该报告的背景和大纲。如今,计算机算法被越来越广泛地应用于实际问题。当算法取代了人成为决策的主体后,我们会关心算法的决策是否合理。公平性和社会福利是衡量算法表现的两种标准。在某些实际问题中,这两种标准可能会互相冲突。于是我们关心这样一个问题:“对算法的公平性的考量如何与经济学中的福利概念联系起来?”

另一方面,在许多实际问题中,人依然是决策的主体,算法的作用在于辅助人的决策。算法可以提供信息、预测、评估等,来帮助人们做决策。一个很自然的问题便是:“算法的辅助如何影响人的判断和决策?”Yiling 在接下来的报告中回答了这两个问题。

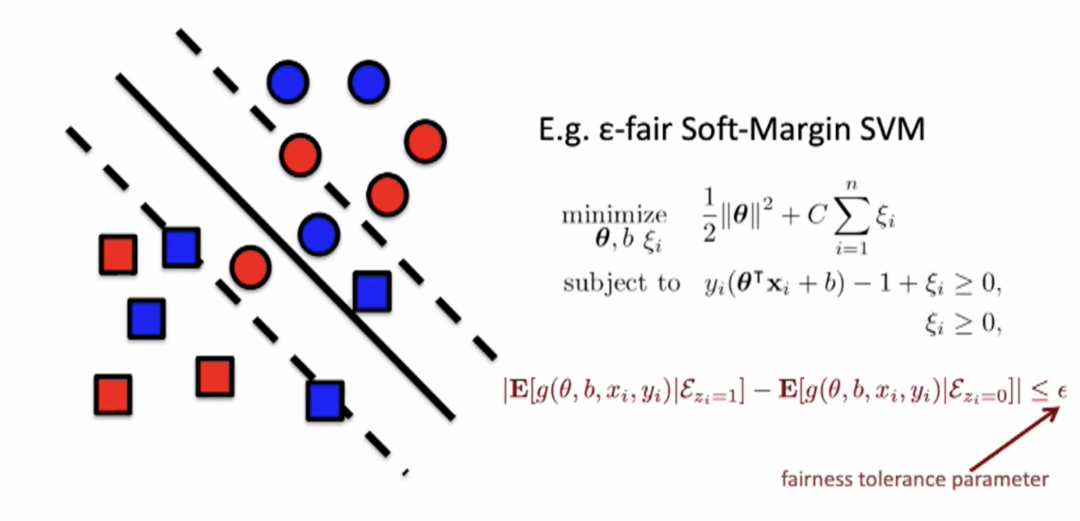

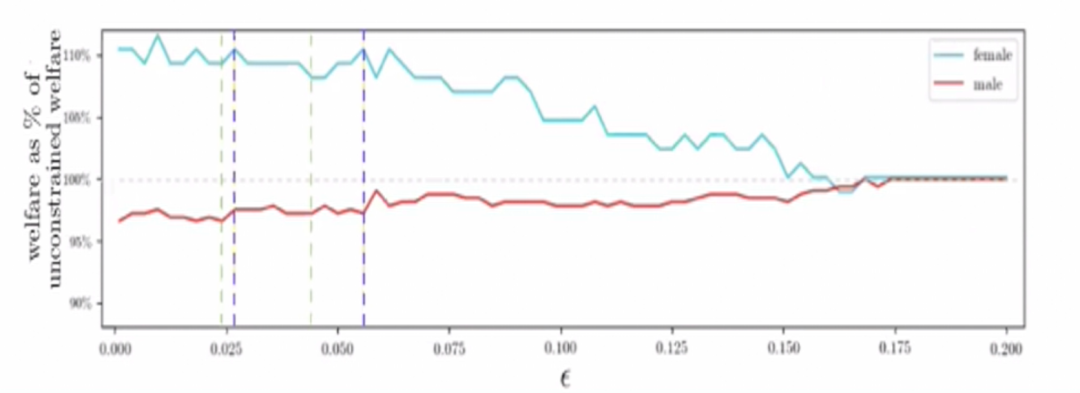

报告的第一部分讨论公平性和福利的问题。Yiling 讨论了在以 SVM 为例的分类算法中,加入公平性约束后,个体的福利会如何变化。一个例子是,银行使用 SVM 来判断是否应该贷款给某个人。我们希望银行的决策对不同群体是公平的,比如男性群体和女性群体。为此,我们在 soft-margin SVM 中添加一个公平性约束,要求算法在两个群体上的表现不能相差太多。“不能相差太多”可以用一个参数 eps 来刻画。eps 越小,算法越公平。eps=0 表示分类器在两个群体上的平均表现是相同的。

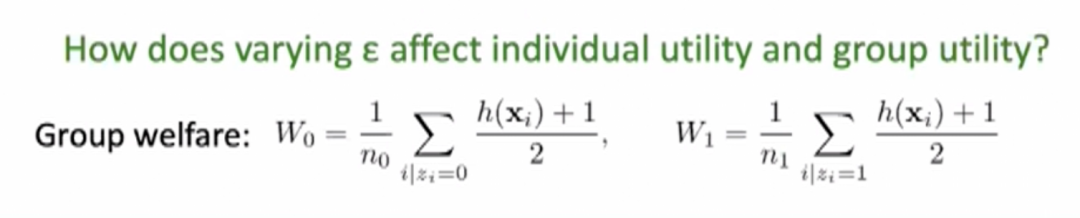

我们关心参数 eps 如何影响不同群体的福利。群体的福利定义为该群体中所有个体的效用的均值(假设个体获得贷款的效用总高于未获得的效用)。

Yiling 在报告中指出,在分类问题中,公平性约束可能会损害社会福利。理论分析发现,当公平性参数 eps 减小时,SVM 输出的分类方案不仅不是帕累托最优,还可能会让所有人的效用降低。证明的思路是分析参数 eps 如何影响 SVM 优化问题的对偶变量。

除了理论分析外,Yiling 还展示了一些实验结果。实际数据集上的实验表明,随着参数 eps 的减小,女性群体的福利呈上升趋势,男性呈下降趋势。这说明,对公平性的要求确实可以改善银行贷款中的性别歧视现象,提升女性福利。然而,在部分区间内,减小 eps 也可能同时降低两个群体的福利(如下图虚线内所示)。

这部分工作是与 Lily Hu 共同完成的。

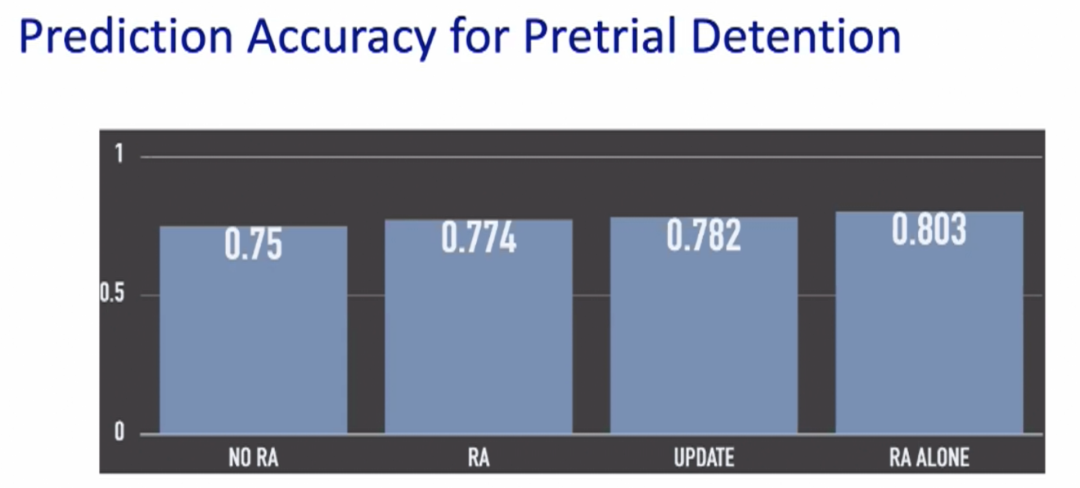

报告的第二部分讨论算法的辅助如何影响人们的判断和决策。该部分是实验性质的工作,通过以人为被试的一系列实验,研究了在审前羁押(pretrial detention)和贷款问题中风险评估算法对人的决策的影响。审前羁押是指嫌疑人被逮捕后,法官需要判断在审理案件之前应该羁押还是释放嫌疑人。风险评估算法可以预测嫌疑人被释放后不会出庭或被再次逮捕的概率,从而帮助法官做出判断。Yiling 讨论了使用风险评估算法的三个方面的影响:一是准确率,即算法的使用是否能让风险评估更准确;二是公平性,即人与算法的交互行为是否会受到种族、性别等敏感属性的影响;三是决策过程,即风险评估算法是否确实改变了人的最终判断。

实验在 Amazon Mechanical Turk 上进行,被试为普通人而非专家;所用的风险评估算法为 boosted decision tree。实验结果如下:

1. 准确率

实验表明,在审前羁押中,算法的介入越多,被试对风险的预测越准确。如下图,左边 NO RA 表示没有算法介入,右边 RA ALONE 是指只使用算法,中间的 RA 和 UPDATE 是两种介入方式(RA 是同时显示嫌疑人的信息和算法的预测后让被试做出预测,UPDATE 是待被试做出预测后再显示算法的预测,允许被试更新)。贷款问题的结论类似。

2. 公平性

不幸的是,实验表明,人与算法的交互会受到种族因素的干扰。下列左图反映了当风险评估算法输出高风险时,被试的预测在算法的影响下会增加多少;该图的数字为嫌疑人是黑人和白人时对应的增加量的差值,差值大于0表示被试对黑人的风险预测更容易受到算法的影响。右图刻画了被试的预测与算法的预测相差多少,同样取黑人与白人的差值,差值依然大于0。UPDATE 这种算法介入方式的差值比 RA 小,说明人与算法的交互受种族因素的干扰的程度与交互方式有关。在该实验中,UPDATE 比 RA 更公平。

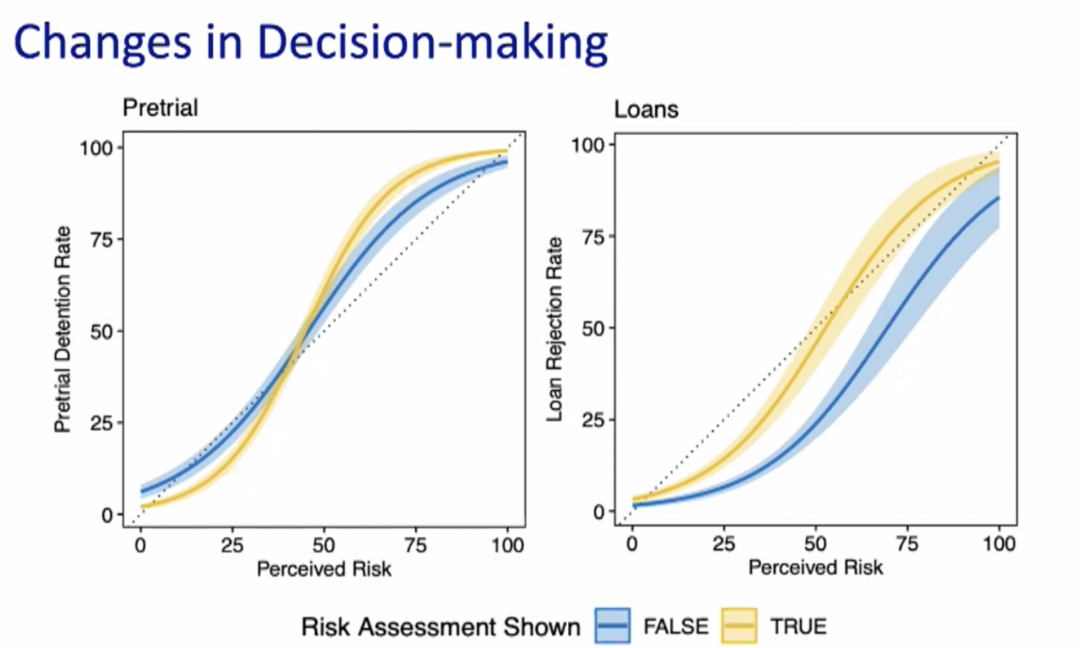

3. 决策过程

前两组实验说明在审前羁押中被试对嫌疑人的风险预测值会受到算法的影响,但法官最终需要决定是否释放嫌疑人,而非给出风险预测值。那么,算法是否最终影响了人的决策呢?根据 Yiling 展示的第三组实验,答案为“是”。如图,曲线为被试决定羁押的概率与他给出的风险预测值的关系。黄色的曲线为算法介入的曲线;蓝色曲线没有算法介入。两条曲线不一致,说明算法的介入确实改变了被试的决策过程。

这部分工作是与 Ben Green 共同完成的。

最后,针对算法决策或算法辅助决策这个大方向,Yiling 总结道:从社会福利的角度看,公平性可能有悖于帕累托最优原则;从人与算法的交互角度看,算法的辅助可以改变人的决策过程,也可能加剧不公平。此外,非常重要的一点是,当我们评估一个用于实际决策的算法时,不能只看算法的表现,必须全面考量其实际应用场景、应用效果、以及与人的交互等因素。