静园5号院前沿讲座:听John Hopcroft教授畅谈AI与深度学习

2019年1月19日,北京大学前沿计算研究中心“静园5号院前沿系列讲座”正式开启。第一讲邀请图灵奖获得者、中国科学院外籍院士、北京大学前沿计算研究中心主任John Hopcroft教授作了题为“An Introduction to AI and Deep Learning”的特邀报告。报告由中心执行主任陈宝权教授主持,听众包括北大信息科学技术学院、数学科学学院、生命科学学院、元培学院等院系,以及清华大学、中国人民大学、台湾大学等高校的师生以及工业界科研人员。

陈宝权教授主持报告

众所周知,人工智能作为信息革命的重要驱动力,正在逐步改变我们的生活。从门禁系统的人脸识别到购物网站的个性化推荐,从智能音箱到游戏AI,从自动驾驶车到智能客服,人工智能渗透到了我们生活的方方面面。机器学习作为人工智能的重要分支,无论是数据模式的识别还是逻辑的推断,都具有强大的威力。而深度学习是机器学习中独特而重要的一环,是近年来真正将人工智能推向大规模应用的支柱。在这样的背景下,John Hopcroft教授精简地概括近年来机器学习方法的主要思路、引导师生们去思考有趣且重要的研究问题,对于培养大家的学术素养大有裨益。

John Hopcroft教授报告现场

Hopcroft教授先简单介绍了一种传统的机器学习方法——支持向量机(SVM)。他从线性分类器出发,引导大家将向量投影到高维空间中以便解决非线性的分类问题,由此引出了核函数(Kernel)。但是如何选择合适的核函数来提取原始数据的特征呢?传统的方法需要大量的经验和领域专家知识,深度学习提供了另外一种思路:让分类器自己来学习如何提取特征。

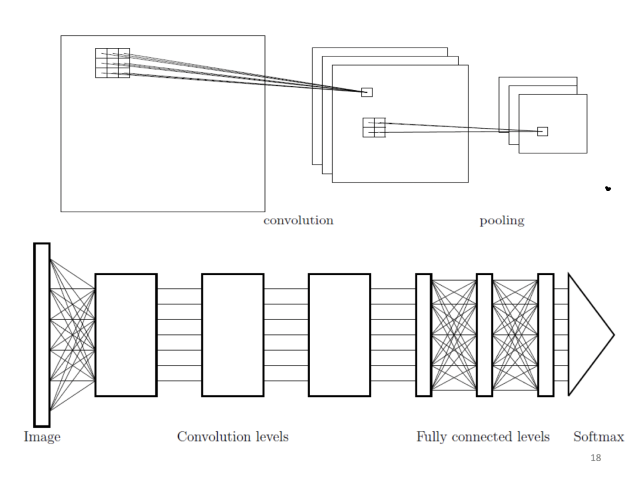

说起深度学习的出现,就不得不提ImageNet目标检测比赛和卷积神经网络(CNN)。2012年,卷积神经网络Alexnet一骑绝尘,将识别错误率从25%降低到15%,正式拉开了深度学习走向应用的序幕。卷积神经网络类似人眼对物体的识别过程,使用卷积核对图片“扫描”,每次得出一小块图片的特征,然后一层一层抽象。前几层可能抽取的是图像中物体的边、拐角,接着几层可能是眼睛、耳朵,最后抽取的是更高维的人脸、猫、狗的表示(Representation)。提特征之后接一层Softmax用于分类,就组成了一个简单的卷积神经网络。

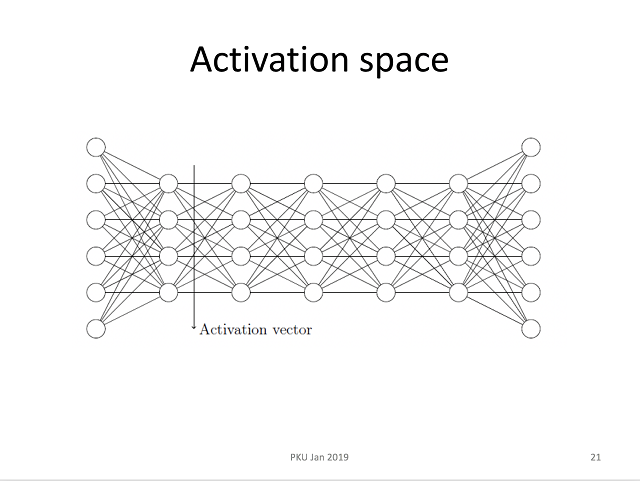

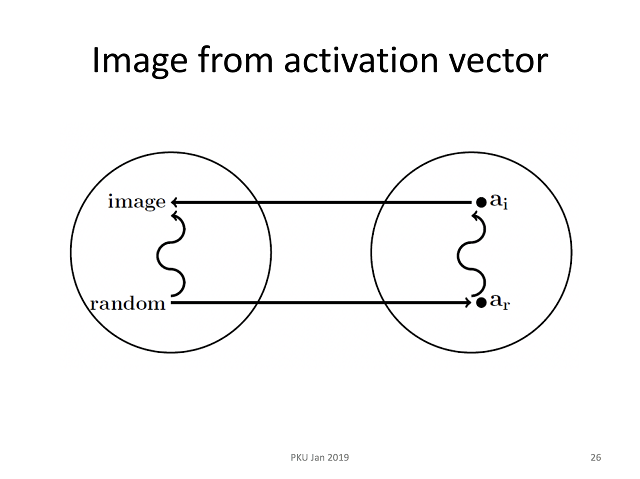

我们可以把神经网络提取到的表示作进一步研究,将神经网络隐层的输出向量称为激活向量(Activation vector),那么我们可以反过来想一个问题:可以用哪些图片得到相似的激活向量呢?

我们可以先从随机生成的图片出发,目标是使得神经网络的表示尽可能相似,逐步优化我们的图片生成器。

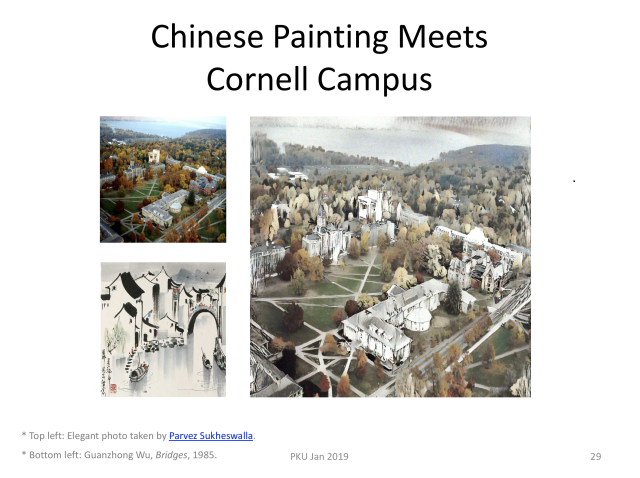

如果还有一张风格的图片作为输入,那么就可以做更多有意思的事情。比如,把康奈尔大学的校园照片变成水墨风格!

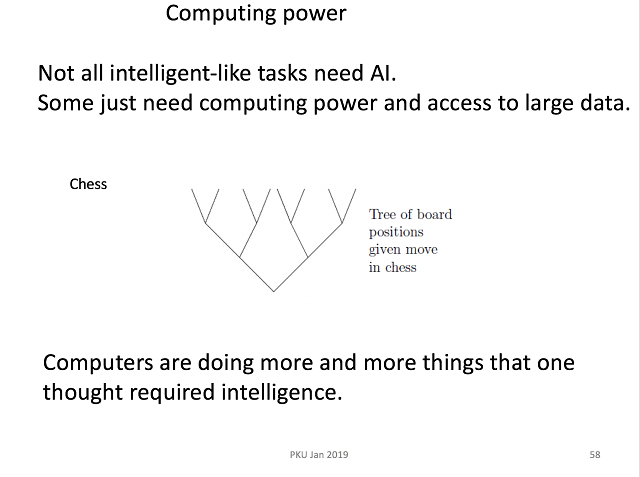

Hopcroft教授同时也指出,人工智能在现阶段不应该被滥用,不能因为它比较流行就想把所有问题都用它来解决。事实上,很多问题只需要计算资源和大量数据。

报告结束后,在座听众就强化学习、深度学习近些年的发展、教育等问题向Hopcroft教授踊跃提问,教授耐心地一一回答。

值得一提的是,Hopcroft教授在下午航班即将返回美国的情况下,依然坚持留出午餐的时间,和图灵班的同学们交流,了解大家的学习情况,认真听取同学们对于学习、生活方面的各种反馈。正如中心一位老师的评价“He loves you guys”,爱在每一个亲切和蔼的笑容、每一个肯定的眼神、每一句鼓励的话语中,默默传递给在座的每一位同学。

报告摘要、报告人简介请见:https://cfcs.pku.edu.cn/announcement/invited_talks/234642.htm