陈宝权课题组SIGGRAPH 2020入选论文解读:从视频到动画的无配对动作风格迁移

论文地址:https://arxiv.org/abs/2005.05751

项目主页:https://deepmotionediting.github.io/style_transfer

项目代码:https://github.com/DeepMotionEditing/deep-motion-editing

* 为共同第一作者

01 引言

“风格”是人类动作的重要组成部分。通过观察一个人走路时的动作细节,我们往往能推测出走路者的情绪、年龄乃至性格。在制作角色动画时,我们也希望生成具有多样风格的动作,从而增强真实感与表现力。传统的动作捕捉技术成本高昂,基于已有动作进行风格迁移——从动作片段 S 中提取风格信息,应用到动作片段 C 的内容上——是更加经济可行的做法。

已有的动作风格迁移方法 [1] 大多依赖于成对训练数据,即内容(如脚步、运动轨迹)完全相同,仅风格不同的动作;此外,它们往往不能迁移训练中从未出现的风格。为了突破这些限制,我们提出了一种新的动作风格迁移框架,直接从无配对、仅含风格标签的训练数据中学习,能在测试阶段迁移从未见过的新风格。进一步地,它能绕过三维重建,直接从二维视频中提取风格,迁移到三维动作上,大大拓展了动作风格迁移的应用范围。

02 方法简介

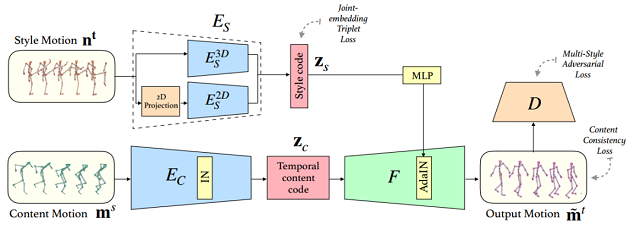

网络结构示意图

我们的网络由生成器和判别器组成,使用包含风格标签的动作训练。生成器以内容动作片段 c、风格为 a 的风格动作片段 s 为输入,输出具有风格 a、但内容与 c 一致的动作 c'。判别器以单个动作片段为输入,对于每个训练风格类,判断输入动作是否是属于该类的真实动作。训练阶段,除生成器-判别器的对抗损失函数外,我们还使用“内容一致性损失”防止生成器直接忽略内容输入:以风格为 a 的内容动作片段 c,风格同样为 a 的另一个风格动作片段 s 为输入,强制生成器重建内容输入 c。

生成器具体包含内容编码器、风格编码器与解码器。内容编码器使用时序卷积将动作编码为包含时序信息的内容向量,并用实例归一化(Instance Normalization)处理中间阶段的特征,破坏其中的风格信息。

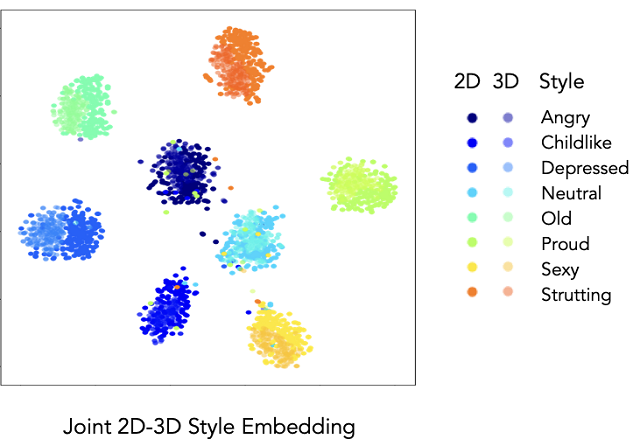

风格编码器使用时序卷积和池化操作,将动作编码为不含时序信息的固定长度风格向量。我们为二维、三维输入各训练了一个编码器,在训练阶段,将三维训练数据与它的二维投影分别作为输入,惩罚输出编码之间的距离,从而使两个风格编码器能把二维/三维的输入映射到同一个风格向量空间。

分别编码自二维、三维动画的风格向量的t-SNE可视化

在解码阶段,我们对内容向量进行卷积与上采样,并采用自适应实例归一化(Adaptive Instance Normalization)注入风格向量的信息:我们将风格向量映射为每个特征的目标均值与标准差,以此为依据逐通道地调整特征。这一调整具有时序不变性,在保留动作时序信息的同时改变其风格信息。

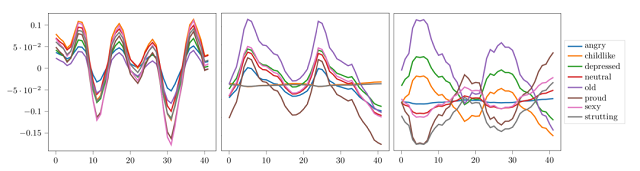

每张图对应一个特征通道,展示了相同时序信号以8种不同的风格向量为输入,经自适应实例归一化后的输出

03 结果展示

我们的方法能够基于内容、风格动作片段给出高质量的迁移结果。输入片段无需具有相似的动作内容。

以三维动画为风格输入的迁移结果

对于视频输入,我们使用 OpenPose [2] 提取骨架信息,将得到的二维动作作为网络的风格动作输入。

以视频为风格输入的迁移结果

从左到右依次是内容动作输入、风格动作输入、[3] 的结果和我们的结果

更多细节请参考以下视频:

参考

[1] Shihong Xia, Congyi Wang, Jinxiang Chai, and Jessica Hodgins. 2015. Realtime style transfer for unlabeled heterogeneous human motion. ACM Transactions on Graphics (TOG) 34, 4 (2015), 119.

[2] Zhe Cao, Gines Hidalgo, Tomas Simon, Shih-En Wei, and Yaser Sheikh. 2018. OpenPose: realtime multi-person 2D pose estimation using Part Affinity Fields. arXiv preprint arXiv:1812.08008 (2018).

[3] Daniel Holden, Jun Saito, and Taku Komura. 2016. A deep learning framework for character motion synthesis and editing. ACM Transactions on Graphics (TOG) 35, 4 (2016), 138.

SIGGRAPH (Special Interest Group on Computer GRAPHics and Interactive Techniques) 是计算机领域规模最大的顶级会议、CCF A类会议,参加人数达2万余人,每年收录百余篇图形学相关的优秀论文,是计算机图形领域集技术、艺术与展览于一体的盛会。因新冠疫情影响,SIGGRAPH 2020将首次以在线方式举行。