王亦洲课题组 CVPR 2023 入选论文解读:从虚拟标记中估计三维人体网格

本文是对发表于计算机视觉领域顶级会议 CVPR 2023 的论文 3D Human Mesh Estimation from Virtual Markers 的解读。该论文由北京大学王亦洲课题组与微软亚洲研究院合作完成。

该工作提出了一种名为虚拟标记(Virtual Marker)的中间表示方法,可以在野外图像中准确检测64个关键点,并从中重建具有逼真人体形态和姿态的完整网格(3D mesh)。实验表明所提方法在三个数据集上优于现有最先进方法,在未见过的图像场景中具有强大的泛化能力。

论文链接:https://arxiv.org/pdf/2303.11726.pdf

项目代码:https://github.com/ShirleyMaxx/VirtualMarker

项目主页:https://shirleymaxx.github.io/virtual_marker/

视频介绍:https://www.youtube.com/watch?v=je2gNUiYl2c

01 背景介绍

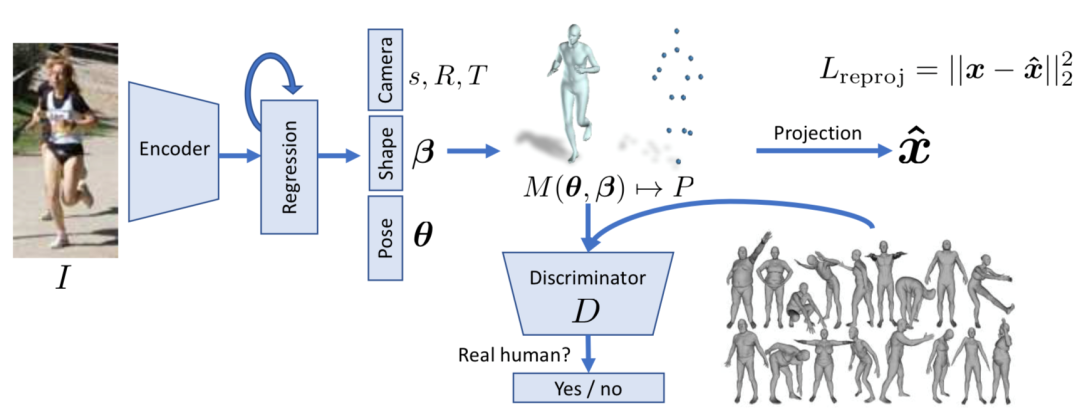

单视角三维人体网格估计是一个具有挑战性的三维视觉任务,具有重要研究意义。先驱方法如 HMR[1]提出从图像直接回归 SMPL 模型的姿态和形态参数(图1)。

图1. 先驱方法 HMR[1]提出从图像直接回归 SMPL 模型的姿态和形态参数

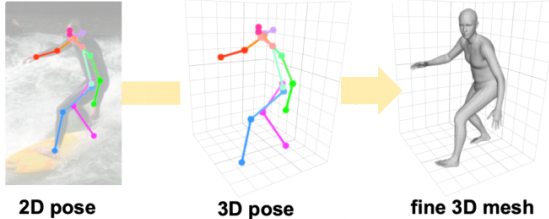

虽然直接,但由于从图像特征到模型参数的映射高度非线性且存在图像-模型不匹配,其精度通常受限。为了缓解学习难度,一些方法提出先引入代理任务以获得中间表示,例如人体骨架(图2a)、物理标记(图2b)等,然后再从中间表示恢复完整的网格。然而,从简化的三维骨架中恢复准确的人体形态很难。物理标记可以解释为身体形态和姿态的简化表示。虽然非常精确,但昂贵且很少有数据集对其进行标记,这限制了它们在没有标记的野外图像中的应用。

图2a. 基于人体骨架表示回归人体网格[2]

图2b. 基于物理标记表示回归人体网格[3]

为此本文提出一种新颖的中间表示方法,称为虚拟标记,它基于大规模动作捕捉数据学习出身体表面上的64个关键点,模仿物理标记的效果。虚拟标记可以从野外图像中准确检测出来,并通过简单的插值重建具有逼真形态的完整网格。

02 方法概览

基于上述相关研究,是否可以在网格上定位一组虚拟标记,类似肘部和手腕,使得这些标记可以从野外图像中检测出来,并可以从中恢复准确的人体形态和姿态。此时该虚拟标记应满足几个要求。首先,标记数量应远小于网格顶点数量,以便可以有效地估计它们的 3D 位置。其次,标记应捕捉网格拓扑结构,以便可以从中准确地回归完整的网格。第三,虚拟标记具有可区分的视觉模式,使其可以从图像中检测出来。为此,本文提出了一种基于原型分析[4]的学习算法,以优化出一组网格顶点的子集作为虚拟标记,并尽可能满足上述要求。图3展示了学习到的虚拟标记,可以看到它们粗略地勾勒出身体形态和姿态。理想情况下,学习到的虚拟标记可以以足够准确的方式重建整个网格(误差在11mm 以内),为估计具有准确形态的网格铺平了道路。

图3. 从大规模动作捕捉数据中学习到的虚拟标记

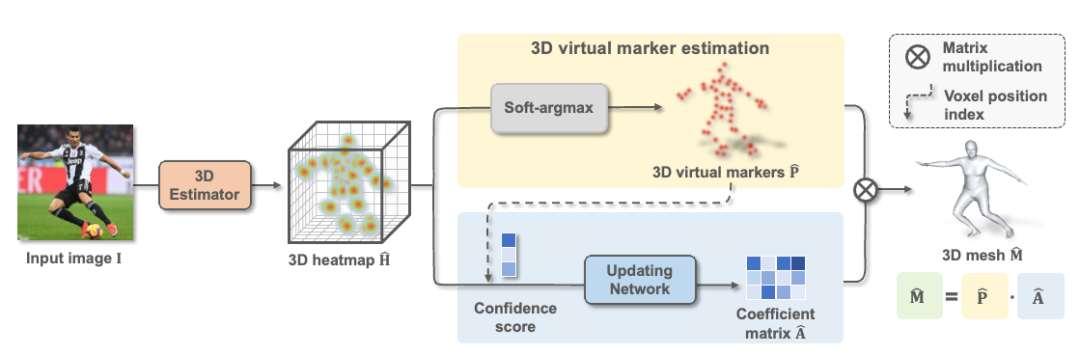

基于虚拟标记表达,我们提出了一个简单而有效的框架(图4),用于从单个图像进行端到端 3D 人体网格估计。它由两个分支组成。第一个分支估计虚拟标记的 3D 位置,第二个分支通过预测系数矩阵重建全网格。然后通过简单地将两个矩阵相乘来重建网格。

因为在实际实践中,一些虚拟标记可能有很大的估计误差,因为它们可能在单目设置中被遮挡。请注意,这种情况经常发生。例如,当一个人面对相机时,后背的虚拟标记将被遮挡。因此,如果我们直接将估计的虚拟标记与固定矩阵 A 相乘,不准确的标记位置可能会给最终网格带来很大的误差。因此,我们的解决方案是更多地依赖那些准确检测到的虚拟标记。为此,我们建议根据虚拟标记的估计置信度分数更新系数矩阵 A。

图4. 模型整体框架,基于虚拟标记表达,动态更新矩阵A用于恢复完整网格

03 实验结论

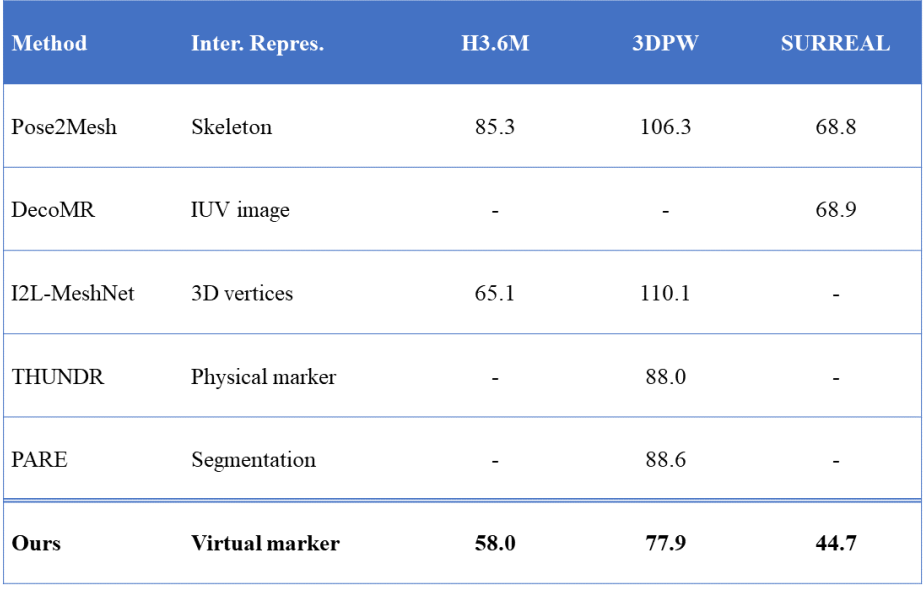

本工作在三个基准数据集上评估了本文的方法,Virtual Marker 均达到了最佳水平并且具有强大的泛化能力。表1展示了在 H3.6M,3DPW 和 SURREAL 三个数据集上的表现,评价指标是预测网格与真实网格的平均格点误差值(MPVE,Mean Per Vertex Error),单位为毫米。

表1. 本工作的方法与现有工作在 H3.6M,3DPW 和 SURREAL 三个数据集上的定量误差结果(越小越好)

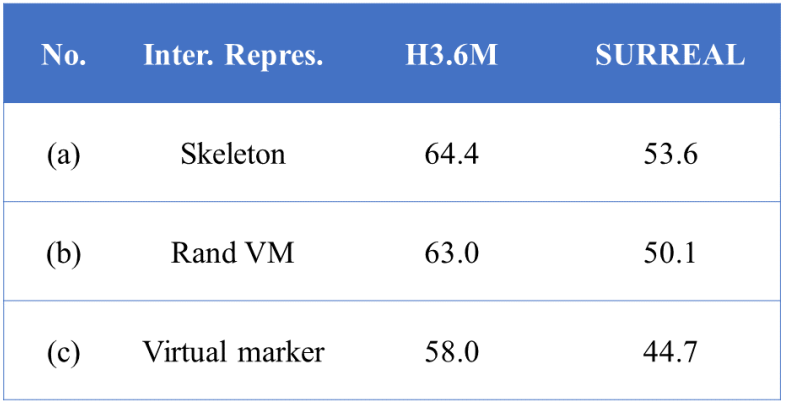

表2展示了在 H3.6M 和 SURREAL 数据集上的虚拟标记表示的消融研究。(a)“Skeleton”意味着使用骨架作为中间表示。(b)“Rand VM”是指虚拟标记是从所有顶点中随机选择的,无需学习。(c) 是本方法,使用了学习到的虚拟标记。结果证明了虚拟标记的有效性。

表2. 在 H3.6M 和 SURREAL 数据集上的虚拟标记表示的消融研究

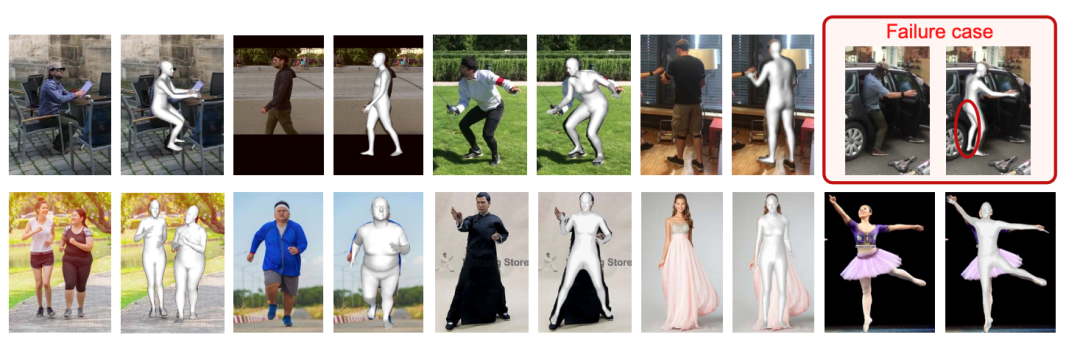

图5展示了本方法的可视化结果,可以看到本工作的方法能准确地估计出人体的形态和姿态,对图像中的背景,遮挡都非常鲁棒。第二行展示了本方法在真实自然图像上的结果,可以看到本方法具有非常强的泛化能力。右上角展示了失败案例,由于严重遮挡,我们的方法对左腿的姿态估计错误,但得益于虚拟标记的数学性质,失败可以控制在局部范围。

图5. 上图:本方法对 3DPW 测试集的图像估计的网格。虚线框中最右边的案例显示了一个典型的失败案例。下图:本方法对挑战性输入(极端形态或长裙)的真实自然图像的方法估计的人体网格

下面展示了更多的本方法在真实自然场景下的可视化效果,验证了该方法的强大泛化能力。

04 总 结

本工作提出了一种新颖的中间表示,虚拟标记,它比流行的骨架表示更具表现力,并且比物理标记更易于获得。它可以更准确、更高效地重建 3D 网格,尤其是在处理各种体型方面。此外,虚拟标记表示中的系数矩阵对网格顶点之间的空间关系进行编码,这使得该方法可以隐式地探索人体的结构先验。它实现了比最先进的方法更好的网格估计结果,尽管它很简单,但显示出先进的泛化潜力。

参考文献

[1] Angjoo Kanazawa, Michael J Black, David W Jacobs, and Jitendra Malik. End-to-end recovery of human shape and pose. In CVPR, pages 7122–7131, 2018.

[2] Hongsuk Choi, Gyeongsik Moon, and Kyoung Mu Lee. Pose2mesh: Graph convolutional network for 3d human pose and mesh recovery from a 2d human pose. In ECCV, pages 769–787, 2020.

[3] Mihai Zanfir, Andrei Zanfir, Eduard Gabriel Bazavan, William T Freeman, Rahul Sukthankar, and Cristian Sminchis- escu. Thundr: Transformer-based 3d human reconstruction with markers. In ICCV, pages 12971–12980, 2021.

[4] Yuansi Chen, Julien Mairal, and Zaid Harchaoui. Fast and robust archetypal analysis for representation learning. In CVPR, pages 1478–1485, 2014.