王鹤课题组 CVPR 2023 入选论文(Highlight)解读:GAPartNet:基于可泛化可交互的零件的跨类别物体感知和操控

本文是国际计算机视觉和模式识别顶级会议 CVPR 2023入选论文 GAPartNet: Cross-Category Domain-Generalizable Object Perception and Manipulation via Generalizable and Actionable Parts 的解读。

该论文由北京大学王鹤课题组与北京通用人工智能研究院、清华大学、加州大学洛杉矶分校合作完成。论文首次提出了一种通过可泛化可操作的零件(GAParts)来学习跨类别物体感知和操控的方法。该研究提供了一个实用的数据集和创新性的跨类研究方法,对于推进通用物体感知和操作的研究具有重要意义。文章在 CVPR 2023中获得全满分的评审成绩并被评为 Highlight(投稿论文的前2.5%)。

项目主页:https://pku-epic.github.io/GAPartNet/

论文地址:https://arxiv.org/abs/2211.05272

代码地址:https://github.com/PKU-EPIC/GAPartNet

01 引 言

通用多功能机器人的核心在于具备通用的物体感知和操作能力。近年来,通用视觉方面的研究主要关注于类别级物体感知,包括从 RGB 图像、点云以及刚体[1]和铰接式物体[2]的类别级位姿估计等,以感知已知物体类别中的新物体实例。而在通用操作方面,也已经有了一些基于类别的复杂任务,例如最近关于学习类别级操作技能的挑战[3],涉及与铰接物体交互的复杂任务。此外,为了提高室内物体的机器人感知和操作能力,研究人员已经提出了几个带有零件分割和运动标注的数据集[4,5,6],并致力于零件分割[4]和铰接信息估计[2]的研究。

图表1. 人类可以将零件的识别和操控泛化到未见过的物体类别

然而,这些工作都是在物体类别内部途径处理物体感知和操作问题的,而人类可以根据先前对按钮、把手、盖子等功能零件的了解,很好地感知和与来自看不见的物体类别的实例进行交互(如图表1)。事实上,同类零件的形状和我们操纵它们的方式的变化比同类物体小得多。因此,我们认为零件类别比物体类别更基本和更重要,并且应该在零件级别上进行通用的视觉感知和操作任务。那么,我们如何定义零件类别?虽然没有单一的答案,但我们提出了一个概念——可泛化可操作零件(Generalizable and Actionable Part,GAPart)类别,这些零件的几何形状和操控方式都是具有通用性的。我们对覆盖1,166个物体的8,489个 GAPart 实例进行了语义标签的标注,并对 GAPart 位姿进行了系统对齐和标注。

基于该数据集,我们又提出了零件分割(Part Segmentation)、零件位姿估计(Part Pose Estimation)和基于零件的物体操作(Part-based Object Manipulation)三项跨物体类别的任务,旨在感知和操控来自已知类别和未知类别的物体。完成这些任务都需要具有跨物体类别(cross-category),也就是域可泛化性(domain-generalizable)的方法,可以处理训练时未见过的物体类别,这对于现有的视觉和机器人算法来说非常具有挑战性。对此,我们创新性地提出了基于域泛化(Domain Generalization)的训练方法并针对我们的感知任务的复杂性进行了精心的设计。这使得我们在零件分割和位姿估计上的表现大幅提高,尤其是在未见过的物体类别上。对于基于零件的物体操控,有了我们预测出来的零件位姿,我们利用 GAPart 的定义就可以使用简单的启发式算法(Heuristics)完成交互。这个方法也在模拟器和真实世界中的未见物体类别上有着良好表现。我们的工作为基于机器学习的物体感知和操作提供了一个新的框架,有望推动机器人在日常环境中更有效地感知和操作物体。同时,我们的工作还为解决跨领域感知问题提供了有价值的参考,为未来机器学习中的泛化研究提供了启示。

02 数据集

1. GAPart 定义

图表2. 我们统一定义了9个零件类,并对他们的位姿和对称性做了详细的分析和定义,图的上部分展示了零件的 NPCS[2]空间

我们为 GAPart 类别提供了严格的定义,它们不仅可以在视觉识别上可以泛化(Generalizable),还共享相似的可操作性(Actionable),对应于 GAPart 中的 G 和 A。我们这样定义的主要目的是为了联系感知和操作任务,允许视觉和交互的联合学习。因此,我们提出了两个原则:第一,具有几何相似性;第二,可操作性一致。基于这些原则,我们定义了27个物体类别中的9个常见的 GAPart 类别。同时,我们为每个 GAPart 类别定义了规范化零件坐标空间(NPCS)中的零件位置和方向,遵循先前的工作[1,2]。我们在图表2中说明了我们的位姿定义。我们注意到,一些 GAPart 类别具有固有的对称性,在处理它们的位姿时我们也给出了相应的设计。基于严格的、以操作为导向的定义,一旦我们知道零件类别和零件位姿,就可以设计简单的启发式方法(Heuristics),实现跨不同物体类别的通用基于零件的操作。

2. GAPartNet 数据集

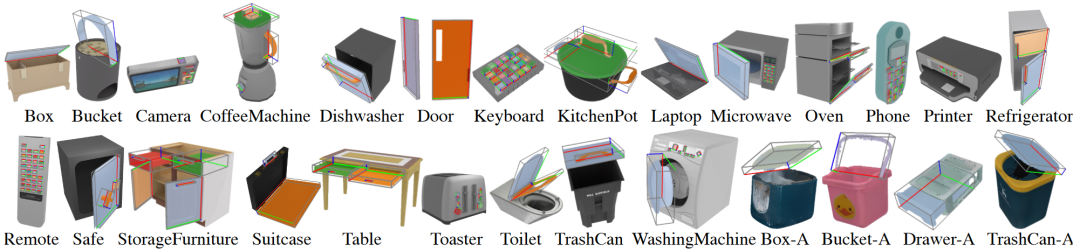

根据 GAPart 定义,我们构建了一个大规模的面向零件的交互式数据集 GAPartNet,为感知和交互任务提供了丰富的零件级别标注。我们的物体来自两个现有数据集,PartNet-Mobility[5]和 AKB-48[6],基于我们的 GAPart 定义进行清理并提供新的统一标注。最终的 GAPartNet 有9个 GAPart 类,为来自27个物体类别的1,166个物体上的8,489个 GAPart 实例提供了语义标签和位姿标注。平均而言,每个物体有7.3个功能零件。每个 GAPart 类别可以在3个以上的物体类别中看到,每个 GAPart 类别平均出现在8.8个物体类别中,为我们的通用零件基准测试打下了基础。图表3,4显示了 GAPartNet 的统计数据和选定示例。

图表3. GAPartNet 数据集包含的27个物体类别

图表4. GAPartNet 数据集的相关统计

03 方 法

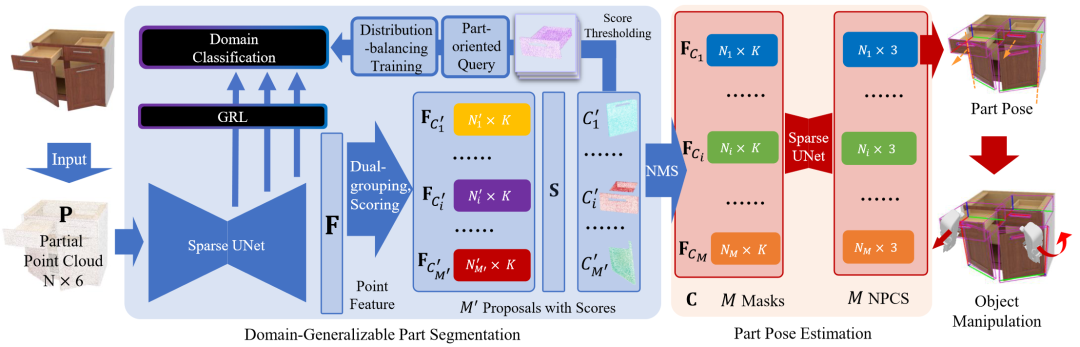

图表5. 我们提出的感知和操控方法的总览

1. 零件分割和零件位姿估计

基于提出的数据集,我们进一步探索了三个基于 GAParts 的跨类别任务:零件分割(Part Segmentation)、零件位姿估计(Part Pose Estimation)和基于零件的物体操作(Part-based Object Manipulation)。我们旨在识别和与已知类别和未知物体类别的新物体的零件进行交互。在这项工作中,我们提出使用基于学习的方法来处理感知任务,然后基于 GAPart 定义,设计简单的启发式方法来实现跨类别物体操作。然而,不同的物体类别可能包含不同类型的 GAParts,并为零件提供不同的上下文(Context)。因此,每个物体类别都形成了感知和操作 GAParts 的域(Domain)。因此,所有三个任务都需要能够在训练期间没有看到它们的情况下在未知物体类别上工作的领域通用方法,这对于现有的视觉和机器人算法来说是非常具有挑战性的。因此,我们参考了域泛化(Domain Generalization)文献[7,8,9]并提出了学习域不变表征(Domain-invariant Representation)的方法,通常通过具有域分类器(Domain Classifier)的域对抗性学习(Domain Adversarial Learning)来实现。在训练过程中,分类器尝试区分不同域,而特征提取器尝试欺骗分类器,这鼓励域不变特征(Domain-invariant Feature)学习。

此外,我们根据任务的复杂性提出了一种面向零件的特征查询技术(Feature Query),该技术主要关注前景零件而忽略背景。为了处理不同的零件尺寸,我们提出了一种多分辨率技术(Multiple Resolution)。最后,我们使用聚焦损失函数(Focal Loss)来处理分布不平衡。实验结果表明我们提出的技术可以很好的处理上述问题并提高感知的泛化性,我们的方法也在实验中明显优于以前的方法。

2. 基于零件的物体操控

给定零件分割和位姿估计,基于所提出的包含可操作性信息的 GAPart 位姿定义,我们为基于零件的物体操作设计了基于零件位姿的有效交互策略,提供了一种跨类别机器人操作和交互任务的新方法。我们首先使用我们的感知方法进行跨类别零件分割和位姿估计。根据零件位姿的预测,我们将机器人手臂移向目标零件,将夹爪转向适合抓取的方向,然后关闭夹爪。最后,我们按照我们的 GAPart 位姿定义,沿着建议的轨迹将夹爪移动到目标位置。结果表明,我们的感知模型和操作启发式可以很好地完成操控,在这些任务上取得良好的性能,并可以泛化到未见过类别的物体。

04 结 果

本节我们展示基于 GAPartNet 数据集的物体感知和操控任务的实验结果,包括定量和可视化的结果。

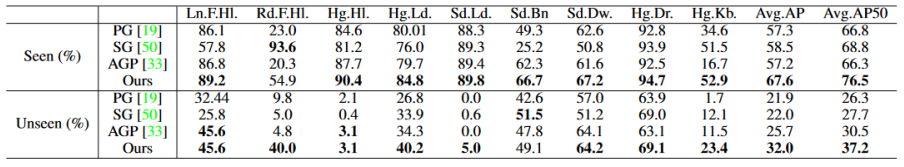

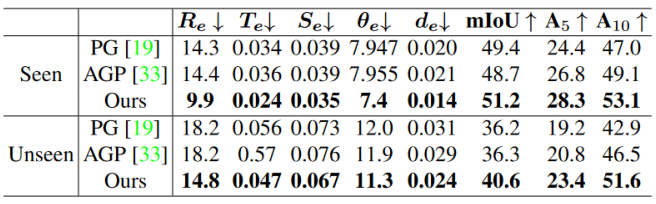

对于零件分割(Part Segmentation)与零件位姿估计(Part Pose Estimation),图表6,7的实验结果表明我们基于域泛化(Domain Generalization)的方法比基线有着更好的表现,尤其是在未见过的物体类别上。

图表6. 在零件分割任务上的表现

图表7. 在零件位姿估计上的表现

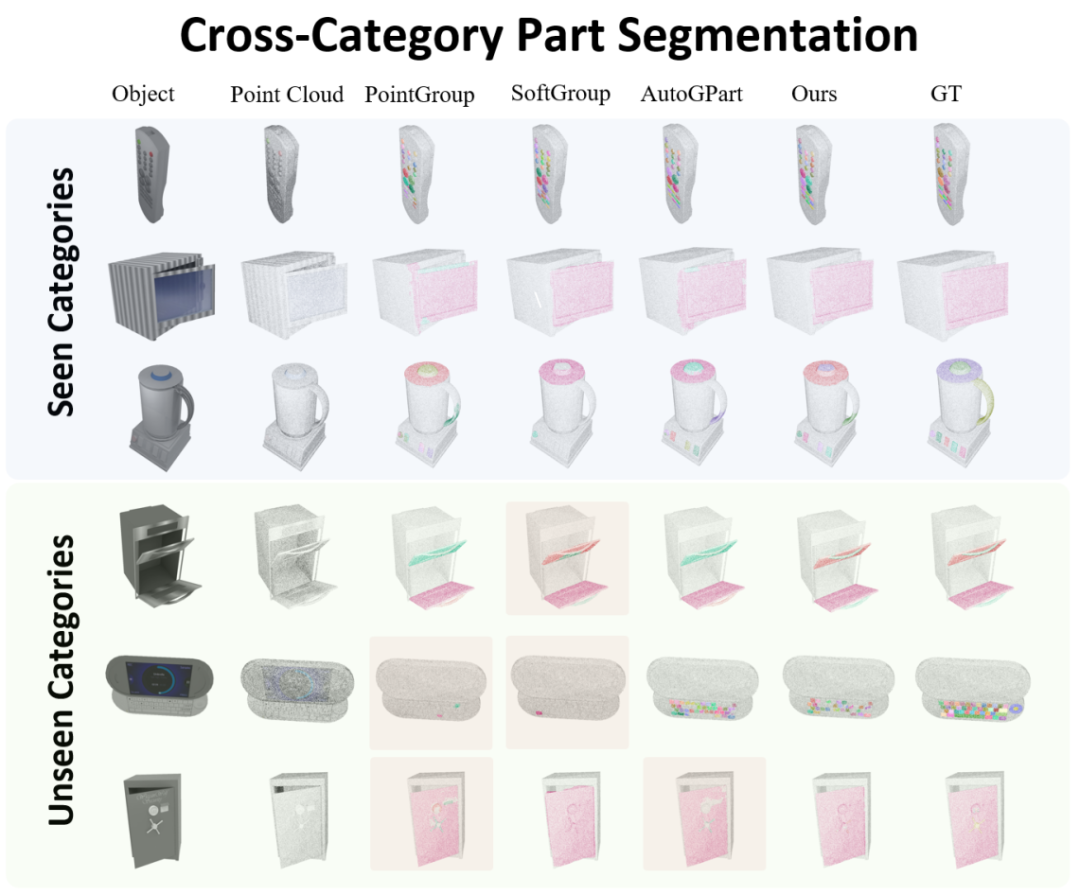

图表8展示了跨类别零件分割的结果,我们将不同方法在可见和不可见类别上的结果可视化,其中红色块显示失败情况。我们的方法有更少的失败案例。特别是在未见类别上,当其他方法的性能显著下降时,我们的方法仍然达到了理想的性能。

图表8. 零件分割结果的可视化

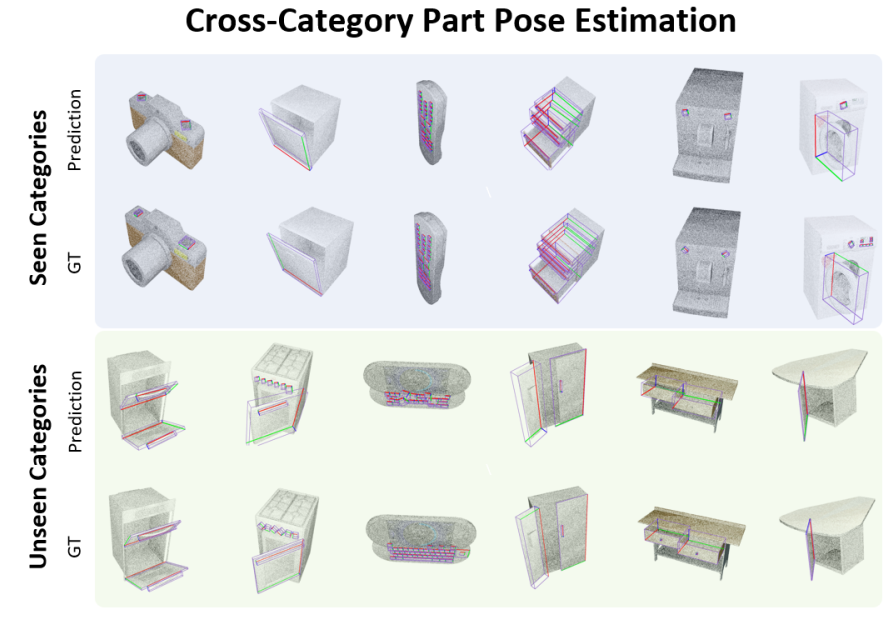

图表9我们展示了位姿估计的可视化结果。我们的方法在未见类别上拥有较好的结果,有着较好的跨类泛化能力。

图表9. 零件位姿估计结果的可视化

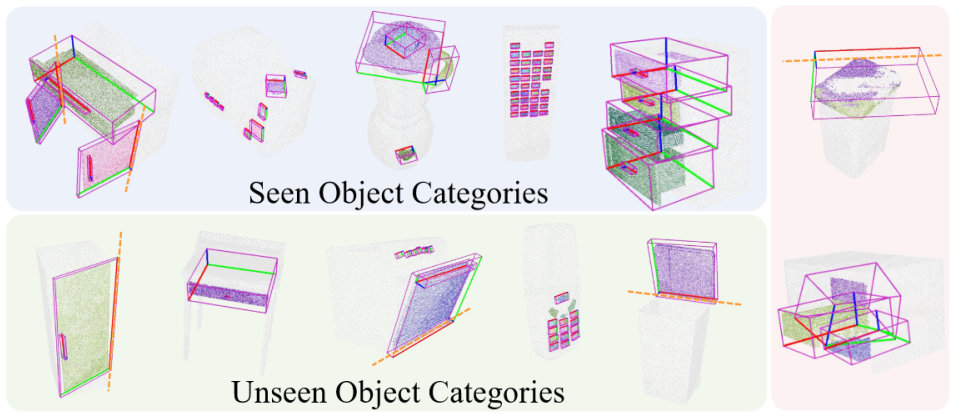

图表10综合展示了这两个任务的可视化结果。左两图显示了跨类别零件分割和位姿估计在已见和未见类别上的结果,而右图显示了部分失败案例。这里我们也展示了零件旋转轴的估计结果。

图表10. 物体感知任务综合可视化以及失败案例

图表11我们展示了在模拟器和现实世界中基于零件的物体操控(Part-based Object Manipulation)结果。我们基于启发式算法(Heuristics)的操控策略也超过了基线方法。

图表11. 基于零件的物体操控结果

下面是我们基于零件的物体操控的可视化:

模拟器中的实验(图表12)表明我们的方法能够实现更多类似人类的交互,而来自 ManiSkill[3]基准的 RL 算法经常试图通过撬和摩擦门或抽屉的边缘来打开门或抽屉,而不是利用把手。

图表12. 模拟器中基于零件的跨物体类别物体操控可视化

我们进一步在现实世界的实验中检验了我们的方法(图表13,14),表明我们的方法对域差异(Domain Gap)具有鲁棒性,从而可以生成可靠的零件分割和位姿估计,最终成功地操控来自未见过物体的零件。

图表13. 现实世界中基于零件的跨物体类别物体操控可视化1

图表14. 现实世界中基于零件的跨物体类别物体操控可视化2

05 总 结

我们引入了 GAPart 的概念,提出了 GAPartNet 数据集,并探索了基于 GAParts 的三个跨类别任务:零件分割,零件位姿估计和基于零件的物体操作。我们提出的方法采用了域泛化(Domain Generalization)技术,在感知和位姿估计方面优于以前的工作。此外,我们设计了基于零件的启发式交互策略,在模拟器和现实世界中都能实现有效可泛化的物体操作。

参考文献

[1] He Wang, Srinath Sridhar, Jingwei Huang, Julien Valentin, Shuran Song, and Leonidas J Guibas. Normalized object coordinate space for category-level 6d object pose and size estimation. In CVPR, 2019.

[2] Xiaolong Li, He Wang, Li Yi, Leonidas Guibas, A Lynn Abbott, and Shuran Song. Category-level articulated object pose estimation. In CVPR, 2020.

[3] Tongzhou Mu, Zhan Ling, Fanbo Xiang, Derek Yang, Xuanlin Li, Stone Tao, Zhiao Huang, Zhiwei Jia, and Hao Su. ManiSkill: Generalizable Manipulation Skill Benchmark with Large-Scale Demonstrations. In NeurIPS, 2021.

[4] Fenggen Yu, Kun Liu, Yan Zhang, Chenyang Zhu, and Kai Xu. Partnet: A recursive part decomposition network for fine-grained and hierarchical shape segmentation. In CVPR, 2019.

[5] Fanbo Xiang, Yuzhe Qin, Kaichun Mo, Yikuan Xia, Hao Zhu, Fangchen Liu, Minghua Liu, Hanxiao Jiang, Yifu Yuan, He Wang, et al. Sapien: A simulated part-based interactive environment. In CVPR, 2020.

[6] Liu Liu, Wenqiang Xu, Haoyuan Fu, Sucheng Qian, Qiaojun Yu, Yang Han, and Cewu Lu. Akb-48: A real-world articulated object knowledge base. In CVPR, 2022.

[7] Yaroslav Ganin and Victor Lempitsky. Unsupervised domain adaptation by backpropagation. In ICML, 2015.

[8] Yaroslav Ganin, Evgeniya Ustinova, Hana Ajakan, Pascal Germain, Hugo Larochelle, Franc ̧ois Laviolette, Mario Marchand, and Victor Lempitsky. Domain-adversarial training of neural networks. In JMLR, 2016.

[9] Haoliang Li, Sinno Jialin Pan, Shiqi Wang, and Alex C Kot. Domain generalization with adversarial feature learning. In CVPR, 2018.