邓小铁课题组 NeurIPS 2022 入选论文解读:基于分队合作的多智能体q值学习方法

本文是 NeurIPS 2022入选论文 Multiagent Q-learning with Sub-team Coordination 的解读。本文得到了华为诺亚方舟实验室的支持,同时也得到了北京大学前沿计算研究中心邓小铁教授、阿尔伯塔大学 MatthewE. Taylor 教授和伦敦学院大学汪军老师的指导与帮助。文章探究了分队组织结构在多智能体值分解问题上的应用,设计了分队组织结构对应的值分解网络,得出了其在值分解问题上具有层级结构的性质,并在对应多智能体场景中验证了算法效果。

01 问题背景

在现实生活中,群体机器人或无人机等问题可以被抽象为多智能体合作问题——多个智能体需要共同完成某一项任务,但该任务只能得到一个整体的评估,没法对每个智能体的行为得到反馈。在这一类问题中,存在一些特殊情况,单个智能体在执行时必须独立进行决策,但可以设计中心化的训练方法对多智能体进行训练。

在多智能体合作问题的训练求解中,可以通过值分解方法,将整体收益函数分解为单个智能体单独的值函数,从而指导每个智能体作出决策。每个智能体在得到分解的函数后,通常贪心地选取智能体值函数最大的策略,因此值分解通常要求保证 IGM 性质[1]:分解后的贪心解是整体的最优解。

现有值分解方法大体有两类:一类是借用单调函数进行分解,这类方法通常容易出现相对过拟合的问题,无法表征最优解方案;另一类是借助优势函数进行间接分解,但现有方法需要将联合动作当作原子项引入分解过程,这一分解能很好的表征解方案,但忽略了智能体个体之间的结构关系。

02 值分解与分队

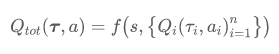

在多智能体合作博弈中,通常使用Q_{t o t}(\boldsymbol{\tau}, \boldsymbol{a}) 表示折现后当前整体收益,用 Q_{i}\left(\tau_{i}, a_{i}\right) 表示单个智能体 i 的值函数,其实 \boldsymbol{\tau}=\left(\tau_{1}, \tau_{2}, ..., \tau_{n}\right) 为联合历史信息。在值分解中一般借助混合函数 f 沟通 Q_{t o t} 和 Q_{i}:

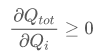

在这里由于中心化训练时可以得到具体的状态 s,可以直接使用状态 s 代替联合历史信息 \boldsymbol{\tau}[2]。例如在 QMIX 论文[3]中,就假设

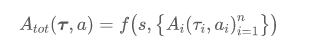

在 QPLEX 论文[4]中,借助值函数 V 优势函数 A 将 Q 函数分解为 Q=V+A,从而在优势函数A_{\text {tot }} 和 A_{i}上进行分解:

我们借助分队结构在优势函数上对分解进行细化,将整体值先分解为分队 ST 的信誉 A_{S T},之后再分配到智能体上。这一分解我们称为 QSCAN。当我们考察所有大小为 k 的分队时,QSCAN_{k} 分解为:

这里 \lambda_{i}(\boldsymbol{\tau}, \boldsymbol{a})是由合作模块得到的权重系数。

03 合作层级与模块设计

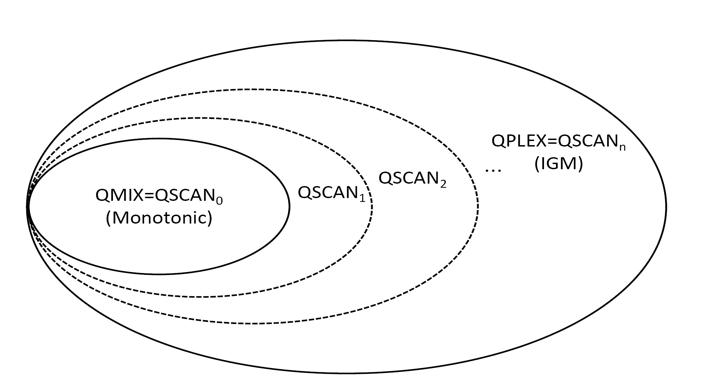

将上述分解进行数学上的延拓后,我们可以得到一类基于分队的分解 Q S C A N_{0}, Q S C A N_{1},..., Q S C A N_{n}。其中对于表征能力,我们有 Q S C A N_{k-1} \subset Q S C A N_{k}。通过数学分析,我们可以得到如下的层级结构:

其中最内层等价于基于单调函数的值分解,最外层等价于所有满足 IGM 性质的分解。

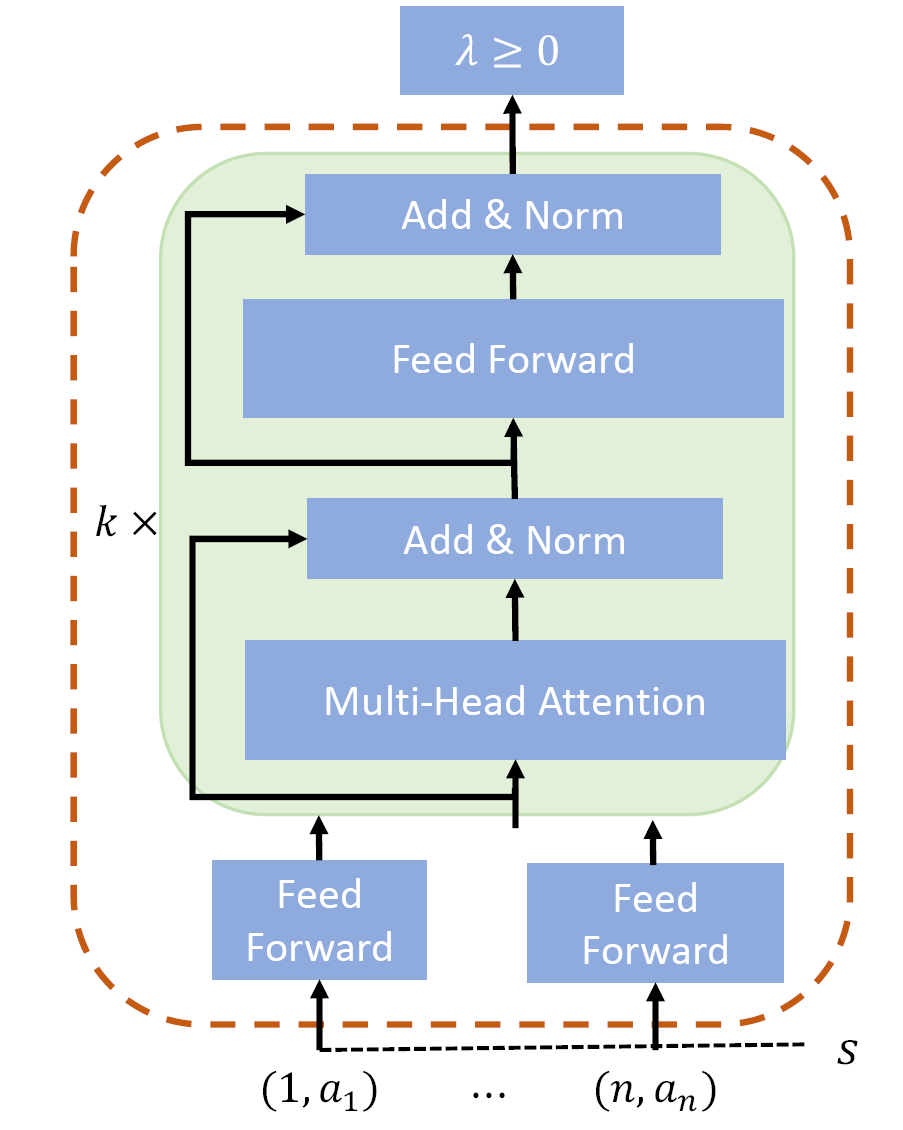

针对不同需求我们设计了两类合作模块,左侧是基于枚举方法的 QPAIR 模块,右侧的是借助 self-attention 灵活表征分队大小的 QSCAN 模块。

04 实验结果

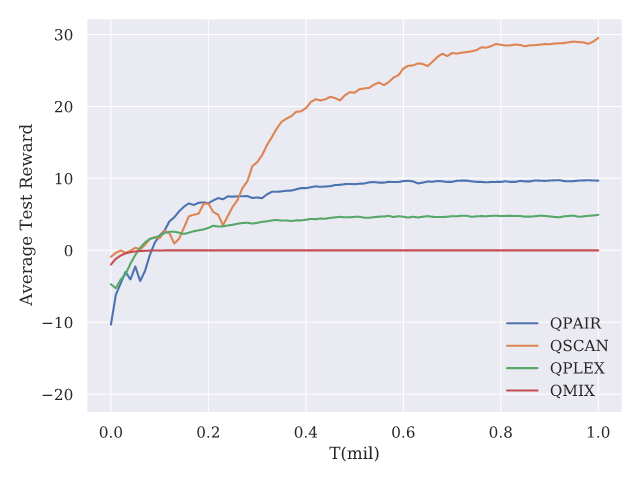

在 Predator-prey[5](左图)和 Switch[6](右图)两个多智能体合作环境中,我们的方法和现有的方法进行对比。实验结果表明我们的方法优于现有方法,说明分队结构在多智能体强化学习中有益于寻找最优解。

参考文献

[1] Son, K., Kim, D., Kang, W. J., Hostallero, D. E., & Yi, Y. (2019, May). Qtran: Learning to factorize with transformation for cooperative multi-agent reinforcement learning. In International conference on machine learning (pp. 5887-5896). PMLR.

[2] Foerster, J., Farquhar, G., Afouras, T., Nardelli, N., & Whiteson, S. (2018, April). Counterfactual multi-agent policy gradients. In Proceedings of the AAAI conference on artificial intelligence (Vol. 32, No. 1).

[3] Rashid, T., Samvelyan, M., Schroeder, C., Farquhar, G., Foerster, J., & Whiteson, S. (2018, July). Qmix: Monotonic value function factorisation for deep multi-agent reinforcement learning. In International conference on machine learning (pp. 4295-4304). PMLR.

[4] Wang, J., Ren, Z., Liu, T., Yu, Y., & Zhang, C. (2020). Qplex: Duplex dueling multi-agent q-learning. arXiv preprint arXiv:2008.01062.

[5] Böhmer, W., Kurin, V., & Whiteson, S. (2020, November). Deep coordination graphs. In International Conference on Machine Learning (pp. 980-991). PMLR.

[6] Koul, A. (2019). ma-gym: Collection of multi-agent environments based on OpenAI gym. GitHub Repository. Available online: https://github. com/koulanurag/ma-gym (accessed on 1 September 2021).