2020年Blum教授主讲“有意识的图灵机”课程小结

新冠疫情期间,北京大学通过云端增进与各国大学、研究机构的合作,充分利用网络实现线上线下教育的深度融合,在“云端”重塑教育形态。

2020年春季,在北京大学首批“外籍访问学者前沿性本科英文课程”项目的支持下,北京大学访问讲席教授、卡耐基梅隆大学讲席教授、1995年图灵奖(A.M. Turing Award)获得者曼纽尔·布卢姆(Manuel Blum)和夫人卡耐基梅隆大学杰出教授贝兰妮·布卢姆(Lenore Blum)通过网络平台首次开设“有意识的图灵机:认知与计算科学(Cognitive/Computer Science of the Conscious Turing Machine)”短期课程,近30名图灵班学生选修或旁听了课程并顺利结课。

关于课程

由于认知神经科学的重大进展,科学开始朝向了解大脑是如何实现意识这一方向发展。1988年,认知神经学家 Bernard Baars 教授提出了 Global workspace theory 和图灵的图灵机计算模型,旨在为人类大脑意识的产生提供一个简单而强大的数学模型。1990年,贝尔实验室的 Seiji Ogawa 等人发明了 fMRI,使神经科学家能够实时见证大脑实时工作。因此,曾经只有哲学家和神学家感兴趣的意识追求,现在开始被各学科的科学家所追求和探索。

这门短期课程主要介绍了三位 Blum 教授设计提出的有意识图灵机(Conscious Turing Machine,CTM)的理论模型,并探讨该形式的属性。该课程属于图灵班的前沿选修课,为期3周,每周3次、共6课时讲授,内容涵盖:

- The Global Workspace Model (GWM)

- The Turing Machine (TM)

- The Conscious Turing Machine (CTM)

- Special LTM Processors for Consciousness

- Pain and Pleasure: The Feelings of Consciousness

- What does consciousness do for computation?

同时,课程以2-3名同学自由组合完成小组作业,平均每次课一份作业,从最初的作业构想、计划,到中期的研究方法,再到最后形成正式的课程报告和小组汇报,分步骤进行。

考虑到时差原因,在上课之余,课程使用 Piazza 平台辅助教学,实现老师与同学随时的问答、沟通与互动。

Blum教授评语

The Peking U undergrads in this class are shockingly bright. Some of them -and add to that also our remarkable TA Chen Yurong - are as bright as any graduate students we have ever taught at CMU and Berkeley, and that includes the 3 Turing Award winners who got their PhD with us.

——Manuel Blum

助教有话说

十分有幸成为 CTM 课程的助教,可以跟着同学们一起学习 Blum 教授的 CTM 这一模型。对于课程内容和设置,事实上这并不是一门学习技术和专业知识的课程,我从中学到的或许是如何思考和科研。这门课的作业事实上是让同学们在上课的过程中完成一个小的科研项目,课程持续三周,每周三节课,每次的项目都要有些新的进展,两位教授会非常负责地看完每个组的作业和进展,并且针对性地给出建议。而从模型本身,我能学到的则是如何去繁从简,抓住模型中最为核心的部分,再用简洁的数学语言将其描述。期待 CTM 这一模型,在未来能有更多的理论结果和实验验证。

两位教授非常和蔼和热情,他们收集了每个同学的照片,记住了每个同学的名字。他们鼓励同学们提问:虽然每节课结束的时候,美国时间已是晚上快10点,教授还是要求大家必须问三个问题才能离开。整个课堂的氛围非常融洽,交互性也很强。再次感谢教授带来了这么精彩的一课。

——助教C同学,CFCS一年级博士生

应Blum教授夫妇要求,由助教整理的学生分布图(隐去名字)

课程内容反馈

在三周的时间内,课程带给我的收获是多方面的。在知识方面,我接触了 CTM,这是一种新的 consciousness 的模型,它将 consciousness 形成的必要成分抽象为 LTM、STM、Up-Tree 等部分,而 STM 中的内容即为意识;在研究方法方面,Manual 和 Lenore 以项目的形式锻炼了我们做研究的方法,并指导我们如何以符合学术规范的方式写作报告。

——C同学

Global Workspace Model 是一个简洁、令人惊讶的模型,它以一种直观生动的说法展示了意识和潜意识的关系。图灵机也是简洁而惊人地强大的一种模型,但是我之前从未想过意识也有可能以一种如此简洁的数学模型来刻画,CTM 中对自由意志的定义和阐释也不同于之前接触的哲学或者心理学的一些定义,这种数学上或者从计算上角度的解释给了我很多的启发。

——D同学

发现 complementary learning system 对于 consciousness、unconsciousness 的有效建模有帮助,同时包含 complementary learning system 的模型可能可以有效地用于连续学习,而 CTM 具有这方面的潜力,对于这类模型的设计也具有启发性意义。

——J同学

课程中主要学到的是如何用最简单的数学结构解释一个关于意识的模型。之前见到的都是通过建立复杂模型来精确模拟人脑中的现象,而这一简单的模型展示出了大脑最基本的能力,有助于我们从数学和哲学的角度理解意识的存在。

——L同学

Blum 教授从理论计算机科学的视⻆去 model 意识并提出了 CTM。我在课上补充了很多神经科学的知识,并且了解了 CTM 模型,给我对意识的认识带来了很新奇的观点。⽐如⽤ chunk 模拟 processor 的计算(我觉得也可以理解成⼀个神经元的意识)然后向上传播到 STM,以及 link 的形成以及使⽤⽅式我觉得都是很有趣⽽且 realistic 的。同学们的报告也很精彩(群众的智慧是⽆穷的),⼤家各⾃提出了⽤ CTM 去解释现象或者给 CTM 添加⼀些机制来完善模型都让我(我悄悄觉得还有 Prof. Blums)对 CTM 有更多更深的理解,并且得到了启发。

——W同学

The concept of CTM provides a novel interdisciplinary view to addressing the problem of consciousness, which is fundamental in understanding both the machine learning and human brain mechanisms. As deep learning has now come into the bottleneck, the integration of consciousness may endow artificial neural networks with a greater ability to generalize on unseen tasks. I am greatly inspired by this "consciousness architecture".

——C同学

在这门课上,我了解到了很多认知科学的知识,也第一次尝试使用熟悉的理论计算机知识去建模认知科学的问题。我和我的队友们针对 CTM 中的决策问题进行了探索,使用了非监督学习的方法来建模。

——X同学

课程感受

Manual 和 Lenore 不仅有着高超的学术水平,对于同学的教导也极为负责和耐心。每一次课程作业,他们都极其认真且详细地给予了反馈,每次作业上都满是逐句手改的笔记。我很庆幸自己选了这门课。

——C同学

我通过课程获得的最大收获,是对于“意识”和“智能”的思考;通过分析一个简单的意识模型和课堂讨论,我对意识的本质,以及“人工智能”的发展有了新的认识和体会。

——Y同学

Lenore 和 Manual 都非常亲切而且幽默,会给我们分享自己的经历、书籍还有视频,我觉得很有收获。比如我正在看他们推荐的一本很神奇的书,My stroke of insight。两位教授也非常随和地跟我们一起探讨问题,我觉得这是我本科上过的所有课中师生之间讨论和互动最充分和热烈的一门课,虽然只有三周的时间,教授已经可以记住我们这么多选课同学的英文甚至中文名字了,然后 Manuel Blum 教授还跟我亲切地用广东话打招呼,感觉两位教授真的是把我们当朋友在交流,感觉很感动很受鼓舞!

——D同学

离去年在图灵大会见到 Blum 教授刚好一年,很惊喜能够再次听他们更加深入地讲授 CTM。除了学术和知识上的收获,两位 Blum 教授还热心地给我们研究方法上的指导,帮助我们规划未来的学术生涯。

——X同学

课程意见

- 希望内容中能够包含一些更加数学的、technical 的内容。

- 希望在 pre 和小组论文的内容上再多一些交流(多预留一到两次课的时间?)。

- 早晨8点有些太早,起床真的很难受(因时差缘故,所有课程均为早8:00开始)。

- 三周的课程有些太密集了,且放在期末季令人送命。建议以后尽量放到假期,或者分摊到半个或整个学期。

作业摘要

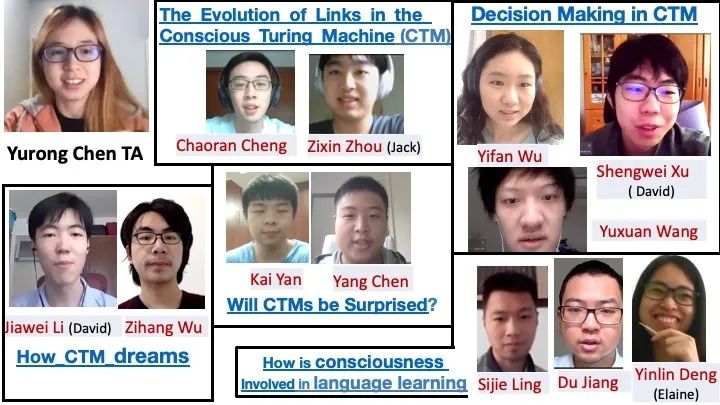

Blum教授夫妇总结的学生作业情况

How CTM dreams of an electric sheep

Zihang Wu, Jiawei Li

Dream is a remarkable experiment that every sleeping person conducts every night. Our brain disconnects from the environment, generates an entire world of conscious experiences, tries risky possibilities safely and learns from it. In this paper, we discuss several aspects of dreams from the viewpoint of CTM theory, and refine the original explanation respectively:

- Some specific "dreamer" processors have reduced weight when dreaming.

- REM dreams have relatively high activation level of LTM processors than NREM dreams.

- Less feedback leads to intense emotion in dreams.

- Memory of dreams is easy to forget due to lack of external cues.

- The reprocess in LTM processors and the evolution of the links during the dream make learning from dream possible.

- Some LTMs related to self-awareness which is inactive during the normal dream is reactived again during the lucid dream.

The evolution of links in the CTM

Chaoran Cheng, Zixin Zhou

The CTM model provides great insights into consciousness, for its conciseness and simplicity allow the possibility of a universal model for consciousness. One crucial dynamic of the CTM, the evolution of links between long term memories (LTM), however, remains inconclusive. In this paper, we argue that this evolution is pivotal for high-level tasks such as learning new knowledge and responding to unexpected events. We also propose the Hebbian CTM model inspired by researches in neuroscience and discuss their compatibility with the current CTM model. One great advantage of our model is that it can deal with the dynamic nature of consciousness and the complex interactions between consciousness and unconsciousness, which, as neural counterparts have shown, are crucial for high-level complicated functionality such as learning and formation of procedural memory.

Will CTMs be surprised: A theory of unexpected Inputs' Influence on CTM

Kai Yan, Yang Chen

In this paper, we discuss how CTM will respond to unexpected input, putting forth a reasonable explanation about different reaction when surprised by different kinds of unexpectedness. Based on different understanding about LTM processor, we propose two models to interpret such phenomenon, i.e., CTM with Divergence and CTM with Labeled Feature Extractor. Both the models explain the differences between fear and laughter upon unexpected input reasonably. Our models justify surprise in CTM qualitatively.

Decision Making of CTM

Yuxuan Wang, Yifan Wu, Shengwei Xu

In a CTM, each Long Term Memory processor produce a “chunk” at each time stamp, which contains a digest of the information by the processor. However, it remains unclear how LTM processors produce a chunk. we apply an information theoretic framework for the LTMs to train their internal decision makers. This scoring system can train the classifiers in a semi-/un-supervised learning setting.

How is consciousness involved in learning a language?

Sijie Ling, Yinlin Deng, Du Jiang

Language is one of the most advanced cognitive functions of human beings. When we are using languages, some of the processes automatically complete in our mind, and some require thought processes which we are conscious of. This paper explores a wide range of research on the neural foundation of processing first language (L1) and second language (L2). Some evidence shows that in L1 processing, there are many brain areas responsible for basic functions, like words storing and grammar analyzing. Network connections of these areas are essential. In L2 processing, the procedure has a lot of differences in activation patterns of the brain. A bilingual brain probably needs multiple processors for L2 and language switching. Finally, we propose some reasonable assumptions that rearranging the processors of semantic and synaptic processing, or a CTM equipped with a complementary learning system may be more suitable for language learning.